- 人工知能研究開発支援

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス(経営者層向けオンサイト研修)

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

- クラスキャット セールス・マーケティング本部 セールス・インフォメーション

- sales-info@classcat.com ; Web: www.classcat.com ; ClassCatJP

BaaS 実装の仮想ブレイン指向知識ベースのチャットボットを2023年11月から提供開始

「ClassCat® Chatbot Second Brain」を2023年11月から提供開始

– GPT 3.5 & 4 連携対応、低コストな知識ベース管理ソリューション –

クラスキャット AI リサーチ (クラスキャット、代表: 佐々木規行、茨城県取手市) は、「ClassCat® ChatBot」シリーズの新製品「ClassCat® Chatbot Second Brain」を2023年11月から提供開始することを発表致しました。「ClassCat® ChatBot」シリーズは GPT 3.5 & 4 との連携に対応した知識ベース管理ソリューションを装備したチャットボットです。多様なドキュメントやリソースを LLM (大規模言語モデル) がリアルタイムで高速に参照可能なコンテキストに変換できますので、管理下にあるドキュメントの内容についてユーザは自在に質問することができます。本ソリューションはオープンソースベースで GPU 不要であるために低コストで運用することができます。

今回発表致しました「ClassCat® Chatbot Second Brain」は BaaS (Banking as a Service) 上に実装されているため堅牢で、また知識ベースを仮想ブレイン (頭脳) 指向で構成しているために知識群の管理が容易であるという大きな特徴を持っています。

[Read More …] (10/17/2023)

GPT 3.5 & 4 連携対応、低コストな知識ベース管理ソリューション、ベータ版を配布開始

「ClassCat® Knowledge Manager」ベータ版を配布開始

– Chat with your documents –

クラスキャット AI リサーチ (クラスキャット、代表: 佐々木規行、茨城県取手市) は、GPT 3.5 & 4 との連携に対応した知識ベース管理ソリューション「ClassCat® Knowledge Manager」ベータ版を配布開始したことを発表致しました。

ClassCat® Knowledge Manager は多様なドキュメントやリソースを、OpenAI GPT 3.5 & 4 (ChatGPT) を始めとする大規模言語モデル (LLM) がチャット中にリアルタイムで参照できるコンテキストに変換できるソリューションです。端的に言えば、”Chat with your documents” つまりユーザがアップロードして管理しているドキュメントの内容についてユーザはチャット、質問応答することができます。

本ソリューションはオープンソースベースで GPU 不要であるために低コストで運用可能です。

[Read More …] (10/03/2023)

⚡ ClassCat® Chatbot Knowledge Manager : ベータ版配布開始

GPT 3.5 & 4 連携、知識ベース管理ソリューション ClassCat® Chatbot Knowledge Manager は、あらゆるドキュメントやリソース・コンテンツを OpenAI GPT 3.5 & 4 (ChatGPT) がチャット中にリアルタイムで参照できるコンテキストに変換できるソリューションです。本ソリューションは利用したい LLM (大規模言語モデル) やベクトルデータベースを選択可能です。

💥 02-oct-23 : Beta 版を github で公開しました。

ギリシャ語 RoBERTa & GPT2 モデル公開

ギリシャ語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットは Wikipedia に加えてクロールデータも利用しています。

- RoBERTa モデル [ ClassCat/roberta-small-greek ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/21/2022)

- GPT2 モデル [ ClassCat/gpt2-small-greek-v2 ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/23/2022)

フランス語 RoBERTa & GPT2 モデル公開

フランス語語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットは Wikipedia に加えてクロールデータも利用しています。

- RoBERTa モデル [ ClassCat/roberta-base-french ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/08/2022)

- GPT2 モデル [ ClassCat/gpt2-base-french ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/11/2022)

クラスキャットでは Transformer ベースの言語モデルの作成を支援しています。

バスク語 RoBERTa & GPT2 モデル公開

バスク語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットはクロールデータを利用しています。

- RoBERTa モデル [ ClassCat/roberta-small-basque ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/19/2022)

- GPT2 モデル [ ClassCat/gpt2-small-basque-v2 ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/18/2022)

カタルーニャ語 RoBERTa & GPT2 モデル公開

カタルーニャ語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットは Wikipedia に加えてクロールデータも利用しています。

- RoBERTa モデル [ ClassCat/roberta-base-catalan ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/01/2022)

- GPT2 モデル [ ClassCat/gpt2-small-catalan-v2 ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/15/2022)

スペイン語 RoBERTa & GPT2 モデル公開

スペイン語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットは Wikipedia に加えてクロールデータも利用しています。

- RoBERTa モデル [ ClassCat/roberta-base-spanish ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (07/01/2022)

- GPT2 モデル [ ClassCat/gpt2-base-spanish ] – Causal 言語モデル, テキスト生成タスクを遂行できます。 (07/03/2022)

クラスキャットでは Transformer ベースの言語モデルの作成を支援しています。

ラテン語 RoBERTa モデル公開

ラテン語 用の以下のモデルを HuggingFace モデルハブで公開しました。データセットはクロールデータを利用しています。

- RoBERTa モデル [ ClassCat/roberta-base-latin-v2 ] – Masked 言語モデル, Fill Mask タスクを遂行できます。 (06/21/2022)

日本語 GPT2 モデル (ClassCat/gpt2-base-japanese-v2)

日本語 用 GPT2 ベースモデル v2 を HuggingFace モデルハブで公開しました。

テキスト生成タスクを遂行できます。本バージョンではトークナイザーを改良し、データセットは Wikipedia に加えてクロールデータも利用しています。

クラスキャットでは Transformer ベースの言語モデルの作成を支援しています。

[詳細] (06/22/2022)

HuggingFace Transformers 4.17 : Notebooks : ゼロからの新しい言語モデルの訓練

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『Notebooks』から「ゼロからの新しい言語モデルの訓練」です。この投稿では、Esperanto 上で “small” モデル (84 M パラメータ = 6 層, 768 隠れサイズ, 12 アテンションヘッド) を訓練する方法を実演します – それは DistilBERT と同じ数の層 & ヘッドです。そして品詞タギングの下流タスクでモデルを再調整します。

[詳細] (05/18/2022)

HuggingFace Transformers 4.17 : Notebooks : 画像分類の再調整

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『Notebooks』から「画像分類の再調整」です。このノートブックは画像分類のための事前訓練済みビジョンモデルをカスタムデータセット上で再調整する方法を示します。

[詳細] (05/13/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 多岐選択

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「多岐選択」です。多岐選択タスクは、幾つかの回答候補がコンテキストと一緒に提供される点以外は、質問応答に似ています。モデルはコンテキストが与えられたとき複数の入力から正しい回答を選択するように訓練されています。

[詳細] (05/04/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 要約

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「要約」です。要約はドキュメントや記事のより短いバージョンを作成します、これは重要な情報の総てを捉えています。翻訳とともに、それは sequence-to-sequence タスクとして定式化できる別の例です。このガイドは abstractive 要約のための BillSum データセットのカリフォルニア州 bill サブセット上で T5 を再調整する方法を示します。

[詳細] (05/03/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 翻訳

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「翻訳」です。翻訳は一つの言語から別の言語にテキストのシークエンスを変換することです。それはビジョンや音声タスクにも拡張できる強力なフレームワークである、sequence-to-sequence 問題として定式化できる幾つかのタスクの一つです。このガイドでは、英語テキストをフランス語に翻訳するために OPUS Books データセットの英-仏サブセット上で T5 を再調整する方法を示します。

[詳細] (05/02/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 言語モデリング

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「言語モデリング」です。言語モデリングはセンテンスの単語を予測します。言語モデリングの 2 つの形式があり、このガイドでは Causal 言語モデリング用の DistilGPT2 と Masked 言語モデリング用の DistilRoBERTa を ELI5 データセットの r/askscience サブセットで再調整する方法を示します。

[詳細] (05/01/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – 質問応答

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「質問応答」です。質問応答タスクは質問が与えられたときに答えを返すものです。このガイドは extractive 質問応答に対して SQuAD データセット上で DistilBERT を再調整する方法を示します。

[詳細] (04/29/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – トークン分類

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「 トークン分類」です。トークン分類はセンテンスの個々のトークンにラベルを割当てます。最も一般的なトークン分類タスクの一つは固有表現認識 (NER) です。NER はセンテンスの各エンティティに対して、人、位置や組織のようなラベルを見つけようとします。

[詳細] (04/28/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用の再調整 – テキスト分類

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド : 下流タスク用の再調整』から「 テキスト分類」です。テキスト分類はラベルやクラスをテキストに割り当てる一般的な NLP タスクで、大手企業の幾つかにより広く使用されるテキスト分類の多くの実践的なアプリケーションがあります。このガイドは映画レビューがポジティブかネガティブかを決定するために IMDb データセット上で DistilBERT を再調整する方法を示します。

[詳細] (04/27/2022)

HuggingFace Transformers 4.17 : ガイド : 下流タスク用にモデルを再調整する方法

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド』から「下流タスク用にモデルを再調整する方法」です。このガイドは一般的な下流タスクに対して HuggingFace Transformers モデルを再調整する方法を示します。データセットを素早くロードして前処理するために HuggingFace Datasets ライブラリを使用し、PyTorch と TensorFlow による訓練のためにそれらを準備します。

[詳細] (04/27/2022)

HuggingFace Transformers 4.17 : ガイド : カスタムモデルの作成

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。4.17 をベースにドキュメントを幾つか翻訳しています。

今回は『ガイド』から「カスタムモデルの作成」です。AutoClass は自動的にモデルアーキテクチャを推測して事前訓練済み configuration と重みをダウンロードします。しかし特定のパラメータに対してより制御を望むユーザは幾つかの基底クラスからカスタム Transformers モデルを作成することができます。このガイドでは AutoClass なしでカスタムモデルを作成する方法を学習します。

[詳細] (04/25/2022)

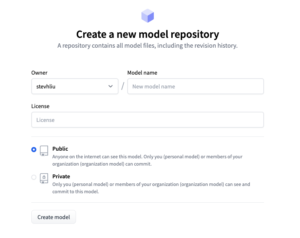

HuggingFace Transformers 4.17 : Tutorials : モデルの共有

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「モデルの共有」です。Hugging Face は、他の人が時間とリソースを節約するのに役立つように、モデルをコミュニティと共有することを奨励しています。このチュートリアルでは、訓練あるいは再調整されたモデルをハブで共有する 2 つの方法を学習します : (1) プログラミング的にファイルをハブにプッシュする。(2) web インターフェイスでファイルをハブにドラッグ&ドロップする。

[詳細] (04/22/2022)

HuggingFace Transformers 4.17 : Tutorials : 多言語モデル

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「多言語モデル」です。利用可能な殆どのモデルは単一言語モデルですが、幾つかの多言語モデルが利用可能です。このドキュメントは多言語をサポートするモデル : XML, BERT, XLM-RoBERTa, M2M100 そして MBart を説明しています。

[詳細] (04/21/2022)

HuggingFace Transformers 4.17 : Tutorials : トークナイザーの概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「トークナイザーの概要」です。テキストのトークン化はそれを単語や部分単語に分割します、これらは検索テーブルを通して id に変換されます。単語や部分単語を id に変換することは簡単ですので、テキストを単語や部分単語を分割することにフォーカスします。

[詳細] (04/19/2022)

HuggingFace Transformers 4.17 : Tutorials : 事前訓練済みモデルの再調整

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「事前訓練済みモデルの再調整」です。このチュートリアルでは、Transformers Trainer, TensorFlow with Keras, そして native PyTorch で事前訓練済みモデルを再調整する方法が紹介されます。事前訓練モデルに使用は大きな利点があります。それは計算コストを削減して、スクラッチから訓練することなく最先端のモデルを利用することを可能にします。Transformers は広範囲のタスクに対して数千の事前訓練済みモデルへのアクセスを提供しています。

[詳細] (04/17/2022)

HuggingFace Transformers 4.17 : Tutorials : モデルの概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「モデルの概要」です。これは HuggingFace Transformers で利用可能なモデルの概要です。個々のモデルは以下のカテゴリーの一つに分類されます :

- 自己回帰モデル

- オートエンコーダ・モデル

- sequence-to-sequence モデル

- マルチモーダル・モデル

- 検索ベースモデル

[詳細] (04/17/2022)

HuggingFace Transformers 4.17 : Tutorials : タスクの概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「タスクの概要」です。このチュートリアルはライブラリを利用するとき頻度の高いユースケースを示します。シークエンス分類、質問応答、言語モデリング、固有表現認識、要約 等々のようなタスクのための使用方法が紹介されます。

[詳細] (04/17/2022)

HuggingFace Transformers 4.17 : Tutorials : 前処理

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「前処理」です。このチュートリアルでは、以下を行ないます : (1) トークナイザーでテキストデータを前処理する、(2) 特徴抽出器で画像や音声データを前処理する、(3) プロセッサでマルチモーダル・タスクのためのデータを前処理する。

[詳細] (04/15/2022)

HuggingFace Transformers 4.17 : Tutorials : AutoClass による事前訓練済みインスタンスのロード

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「AutoClass による事前訓練済みインスタンスのロード」です。Hugging Transformers 哲学の一部として、AutoClass はチェックポイントから正しいアーキテクチャを自動的に推測してロードします。このチュートリアルでは、事前訓練済みのトークナイザー, 特徴抽出器, プロセッサ, モデルのロードについて学習します。

[詳細] (04/12/2022)

HuggingFace Transformers 4.17 : Tutorials : 推論のためのパイプライン

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Tutorials』から「推論のためのパイプライン」です。pipeline() 関数はテキスト生成, 画像セグメンテーション, そして音声分類のような様々なタスクに対して、推論のためにモデルハブから適切なモデルを使用することを単純にします。

[詳細] (04/11/2022)

HuggingFace Transformers 4.17 : Get Started : 用語集

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Get Started』から「用語集」です。基本的な一般用語について簡単に説明された後、モデルへの入力について詳述されます。

[詳細] (04/11/2022)

HuggingFace Transformers 4.17 : Get Started : 哲学

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Get Started』から「哲学」です。HuggingFace Transformers の幾つかの目標と主要コンセプトについて説明されます。

[詳細] (04/10/2022)

HuggingFace Transformers 4.17 : Get Started : クイック・ツアー

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

4.17 をベースにドキュメントを幾つか翻訳しています。今回は『Get Started』から「クイック・ツアー」です。テキスト, 画像と音声についてサポートされる主なタスクと、基本的な利用方法である pipeline() と AutoClass (AutoTokenizer, AutoModel) が簡潔に説明されます。

[詳細] (04/09/2022)

HuggingFace Transformers 4.17 : 概要

HuggingFace Transformers は、テキスト, ビジョン, そして音声のような多様なタスクを遂行する数千の事前訓練済みモデルを提供しています。HuggingFace Transformers は 3 つの最もポピュラーな深層学習ライブラリ – Jax, PyTorch と TensorFlow により、シームレスな統合によって支援されます。

活発にモデルが追加されていますので、4.17 をベースにドキュメントを幾つか翻訳していきます。最初は概要 (README) です。簡単な利用方法と利点、オンラインデモ、モデルのリスト等が説明されます。

[詳細] (04/08/2022)

◆ お問合せ

本件に関するお問い合わせ先は下記までお願いいたします。

| クラスキャット |

| セールス・マーケティング本部 セールス・インフォメーション |

| E-Mail:sales-info@classcat.com |

| WebSite: http://www.classcat.com/ |

※ その他、記載されている会社名・製品名は各社の登録商標または商標です。