ホーム » sales-info の投稿 (ページ 2)

作者アーカイブ: sales-info

MONAI 1.0 : tutorials : 2D 分類 – MedNIST データセットによる医用画像分類

MONAI 1.0 : tutorials : 2D 分類 – MedNIST データセットによる医用画像分類 (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 11/01/2022 (1.0.1)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

- 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション

- sales-info@classcat.com ; Web: www.classcat.com ; ClassCatJP

MONAI 1.0 : tutorials : 2D 分類 – MedNIST データセットによる医用画像分類

このノートブックは MONAI 機能を既存の PyTorch プログラムに容易に統合する方法を示します。それは MedNIST データセットに基づいています、これは初心者のためにチュートリアルとして非常に適切です。このチュートリアルはまた MONAI 組込みのオクルージョン感度の機能も利用しています。

このチュートリアルでは、MedNIST データセットに基づく end-to-end な訓練と評価サンプルを紹介します。

以下のステップで進めます :

- 訓練とテスト用のデータセットを作成する。

- データを前処理するために MONAI 変換を利用します。

- 分類のために MONAI から DenseNet を利用します。

- モデルを PyTorch プログラムで訓練します。

- テストデータセット上で評価します。

環境のセットアップ

!python -c "import monai" || pip install -q "monai-weekly[pillow, tqdm]"

!python -c "import matplotlib" || pip install -q matplotlib

%matplotlib inline

インポートのセットアップ

# Copyright 2020 MONAI Consortium

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

# http://www.apache.org/licenses/LICENSE-2.0

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

import os

import shutil

import tempfile

import matplotlib.pyplot as plt

import PIL

import torch

import numpy as np

from sklearn.metrics import classification_report

from monai.apps import download_and_extract

from monai.config import print_config

from monai.data import decollate_batch, DataLoader

from monai.metrics import ROCAUCMetric

from monai.networks.nets import DenseNet121

from monai.transforms import (

Activations,

EnsureChannelFirst,

AsDiscrete,

Compose,

LoadImage,

RandFlip,

RandRotate,

RandZoom,

ScaleIntensity,

)

from monai.utils import set_determinism

print_config()

MONAI version: 0.9.dev2152

Numpy version: 1.19.5

Pytorch version: 1.10.0+cu111

MONAI flags: HAS_EXT = False, USE_COMPILED = False

MONAI rev id: c5bd8aff8ba461d7b349eb92427d452481a7eb72

Optional dependencies:

Pytorch Ignite version: NOT INSTALLED or UNKNOWN VERSION.

Nibabel version: 3.0.2

scikit-image version: 0.18.3

Pillow version: 7.1.2

Tensorboard version: 2.7.0

gdown version: 3.6.4

TorchVision version: 0.11.1+cu111

tqdm version: 4.62.3

lmdb version: 0.99

psutil version: 5.4.8

pandas version: 1.1.5

einops version: NOT INSTALLED or UNKNOWN VERSION.

transformers version: NOT INSTALLED or UNKNOWN VERSION.

mlflow version: NOT INSTALLED or UNKNOWN VERSION.

For details about installing the optional dependencies, please visit:

https://docs.monai.io/en/latest/installation.html#installing-the-recommended-dependencies

データディレクトリのセットアップ

MONAI_DATA_DIRECTORY 環境変数でディレクトリを指定できます。これは結果をセーブしてダウンロードを再利用することを可能にします。指定されない場合、一時ディレクトリが使用されます。

directory = os.environ.get("MONAI_DATA_DIRECTORY")

root_dir = tempfile.mkdtemp() if directory is None else directory

print(root_dir)

/workspace/data/medical

データセットをダウンロードする

MedMNIST データセットは TCIA, RSNA Bone Age チャレンジ と NIH Chest X-ray データセット からの様々なセットから集められました。

データセットは Dr. Bradley J. Erickson M.D., Ph.D. (Department of Radiology, Mayo Clinic) のお陰により Creative Commons CC BY-SA 4.0 ライセンス のもとで利用可能になっています。

MedNIST データセットを使用する場合、出典を明示してください。

resource = "https://github.com/Project-MONAI/MONAI-extra-test-data/releases/download/0.8.1/MedNIST.tar.gz"

md5 = "0bc7306e7427e00ad1c5526a6677552d"

compressed_file = os.path.join(root_dir, "MedNIST.tar.gz")

data_dir = os.path.join(root_dir, "MedNIST")

if not os.path.exists(data_dir):

download_and_extract(resource, compressed_file, root_dir, md5)

再現性のために決定論的訓練を設定する

set_determinism(seed=0)

データセットフォルダから画像ファイル名を読む

まず最初に、データセットファイルを確認して幾つかの統計情報を表示します。

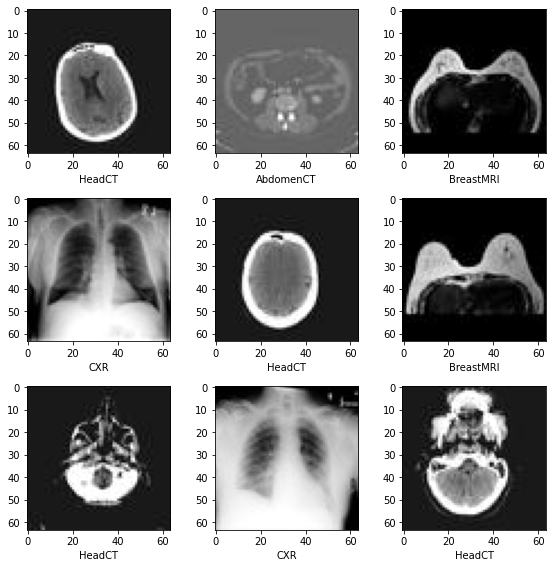

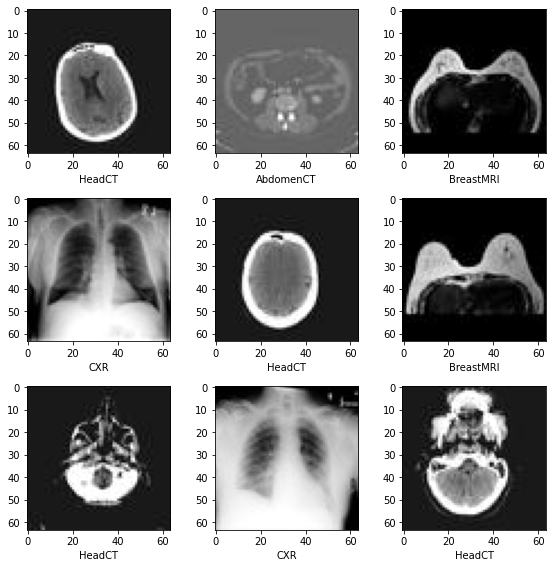

データセットには 6 つのフォルダがあります : Hand, AbdomenCT, CXR, ChestCT, BreastMRI, HeadCT,

これらは分類モデルを訓練するためのラベルとして使用されるべきです。

class_names = sorted(x for x in os.listdir(data_dir)

if os.path.isdir(os.path.join(data_dir, x)))

num_class = len(class_names)

image_files = [

[

os.path.join(data_dir, class_names[i], x)

for x in os.listdir(os.path.join(data_dir, class_names[i]))

]

for i in range(num_class)

]

num_each = [len(image_files[i]) for i in range(num_class)]

image_files_list = []

image_class = []

for i in range(num_class):

image_files_list.extend(image_files[i])

image_class.extend([i] * num_each[i])

num_total = len(image_class)

image_width, image_height = PIL.Image.open(image_files_list[0]).size

print(f"Total image count: {num_total}")

print(f"Image dimensions: {image_width} x {image_height}")

print(f"Label names: {class_names}")

print(f"Label counts: {num_each}")

Total image count: 58954 Image dimensions: 64 x 64 Label names: ['AbdomenCT', 'BreastMRI', 'CXR', 'ChestCT', 'Hand', 'HeadCT'] Label counts: [10000, 8954, 10000, 10000, 10000, 10000]

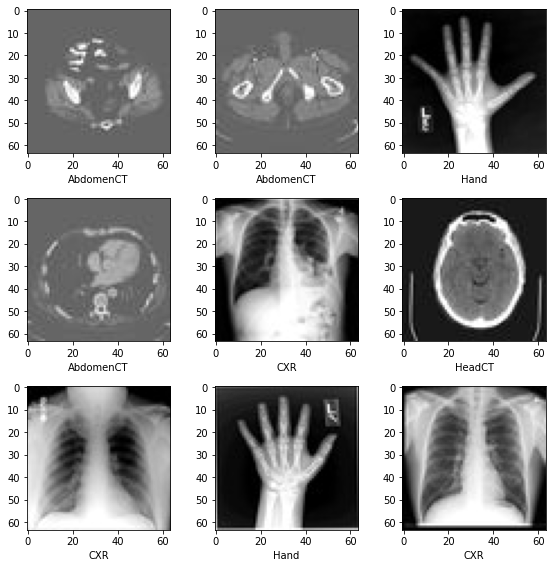

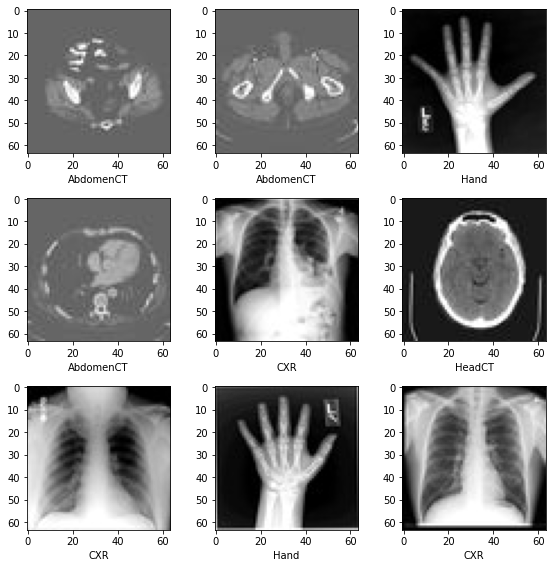

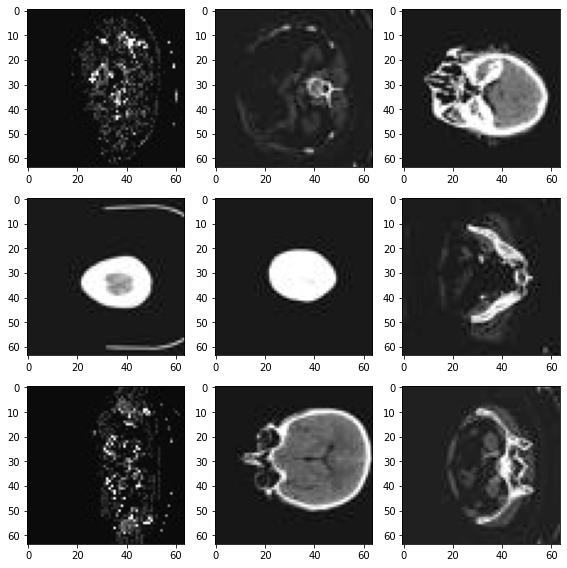

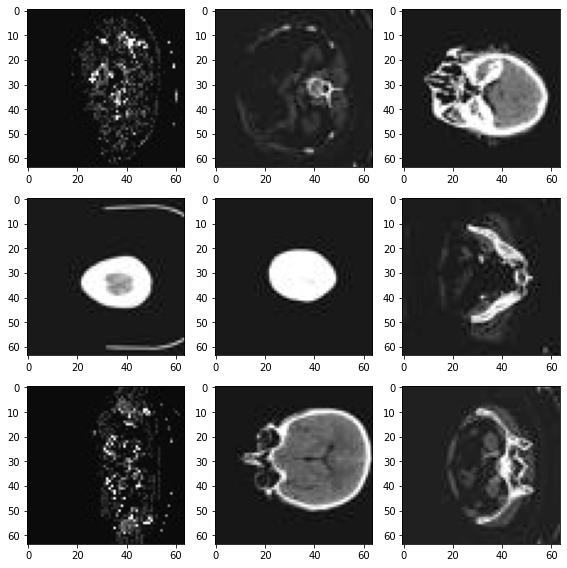

データセットから画像をランダムに選択して可視化して確認する

plt.subplots(3, 3, figsize=(8, 8))

for i, k in enumerate(np.random.randint(num_total, size=9)):

im = PIL.Image.open(image_files_list[k])

arr = np.array(im)

plt.subplot(3, 3, i + 1)

plt.xlabel(class_names[image_class[k]])

plt.imshow(arr, cmap="gray", vmin=0, vmax=255)

plt.tight_layout()

plt.show()

訓練、検証とテストデータのリストを準備する

データセットの 10% を検証用に、そして 10% をテスト用にランダムに選択します。

val_frac = 0.1

test_frac = 0.1

length = len(image_files_list)

indices = np.arange(length)

np.random.shuffle(indices)

test_split = int(test_frac * length)

val_split = int(val_frac * length) + test_split

test_indices = indices[:test_split]

val_indices = indices[test_split:val_split]

train_indices = indices[val_split:]

train_x = [image_files_list[i] for i in train_indices]

train_y = [image_class[i] for i in train_indices]

val_x = [image_files_list[i] for i in val_indices]

val_y = [image_class[i] for i in val_indices]

test_x = [image_files_list[i] for i in test_indices]

test_y = [image_class[i] for i in test_indices]

print(

f"Training count: {len(train_x)}, Validation count: "

f"{len(val_x)}, Test count: {len(test_x)}")

Training count: 47156, Validation count: 5913, Test count: 5885

データを前処理するために MONAI 変換、Dataset と Dataloader を定義する

train_transforms = Compose(

[

LoadImage(image_only=True),

EnsureChannelFirst(),

ScaleIntensity(),

RandRotate(range_x=np.pi / 12, prob=0.5, keep_size=True),

RandFlip(spatial_axis=0, prob=0.5),

RandZoom(min_zoom=0.9, max_zoom=1.1, prob=0.5),

]

)

val_transforms = Compose(

[LoadImage(image_only=True), EnsureChannelFirst(), ScaleIntensity()])

y_pred_trans = Compose([Activations(softmax=True)])

y_trans = Compose([AsDiscrete(to_onehot=num_class)])

class MedNISTDataset(torch.utils.data.Dataset):

def __init__(self, image_files, labels, transforms):

self.image_files = image_files

self.labels = labels

self.transforms = transforms

def __len__(self):

return len(self.image_files)

def __getitem__(self, index):

return self.transforms(self.image_files[index]), self.labels[index]

train_ds = MedNISTDataset(train_x, train_y, train_transforms)

train_loader = DataLoader(

train_ds, batch_size=300, shuffle=True, num_workers=10)

val_ds = MedNISTDataset(val_x, val_y, val_transforms)

val_loader = DataLoader(

val_ds, batch_size=300, num_workers=10)

test_ds = MedNISTDataset(test_x, test_y, val_transforms)

test_loader = DataLoader(

test_ds, batch_size=300, num_workers=10)

ネットワークと optimizer を定義する

- バッチ毎にモデルがどのくらい更新されるかについて学習率を設定します。

- 総エポック数を設定します、シャッフルしてランダムな変換を行ないますので、総てのエポックの訓練データは異なります。

そしてこれは get start チュートリアルに過ぎませんので、4 エポックだけ訓練しましょう。

10 エポック訓練すれば、モデルはテストデータセット上で 100% 精度を達成できます。

- MONAI からの DenseNet を使用して GPU デバイスに移します、この DenseNet は 2D と 3D 分類タスクの両方をサポートできます。

- Adam optimizer を使用します。

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

model = DenseNet121(spatial_dims=2, in_channels=1,

out_channels=num_class).to(device)

loss_function = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), 1e-5)

max_epochs = 4

val_interval = 1

auc_metric = ROCAUCMetric()

モデル訓練

典型的な PyTorch 訓練を実行します、これはエポック・ループとステップ・ループを実行して、総てのエポック後に検証を行ないます。ベストの検証精度を得た場合、モデル重みをファイルにセーブします。

best_metric = -1

best_metric_epoch = -1

epoch_loss_values = []

metric_values = []

for epoch in range(max_epochs):

print("-" * 10)

print(f"epoch {epoch + 1}/{max_epochs}")

model.train()

epoch_loss = 0

step = 0

for batch_data in train_loader:

step += 1

inputs, labels = batch_data[0].to(device), batch_data[1].to(device)

optimizer.zero_grad()

outputs = model(inputs)

loss = loss_function(outputs, labels)

loss.backward()

optimizer.step()

epoch_loss += loss.item()

print(

f"{step}/{len(train_ds) // train_loader.batch_size}, "

f"train_loss: {loss.item():.4f}")

epoch_len = len(train_ds) // train_loader.batch_size

epoch_loss /= step

epoch_loss_values.append(epoch_loss)

print(f"epoch {epoch + 1} average loss: {epoch_loss:.4f}")

if (epoch + 1) % val_interval == 0:

model.eval()

with torch.no_grad():

y_pred = torch.tensor([], dtype=torch.float32, device=device)

y = torch.tensor([], dtype=torch.long, device=device)

for val_data in val_loader:

val_images, val_labels = (

val_data[0].to(device),

val_data[1].to(device),

)

y_pred = torch.cat([y_pred, model(val_images)], dim=0)

y = torch.cat([y, val_labels], dim=0)

y_onehot = [y_trans(i) for i in decollate_batch(y, detach=False)]

y_pred_act = [y_pred_trans(i) for i in decollate_batch(y_pred)]

auc_metric(y_pred_act, y_onehot)

result = auc_metric.aggregate()

auc_metric.reset()

del y_pred_act, y_onehot

metric_values.append(result)

acc_value = torch.eq(y_pred.argmax(dim=1), y)

acc_metric = acc_value.sum().item() / len(acc_value)

if result > best_metric:

best_metric = result

best_metric_epoch = epoch + 1

torch.save(model.state_dict(), os.path.join(

root_dir, "best_metric_model.pth"))

print("saved new best metric model")

print(

f"current epoch: {epoch + 1} current AUC: {result:.4f}"

f" current accuracy: {acc_metric:.4f}"

f" best AUC: {best_metric:.4f}"

f" at epoch: {best_metric_epoch}"

)

print(

f"train completed, best_metric: {best_metric:.4f} "

f"at epoch: {best_metric_epoch}")

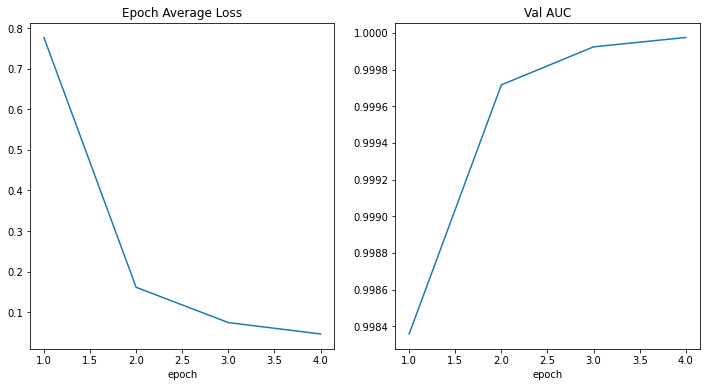

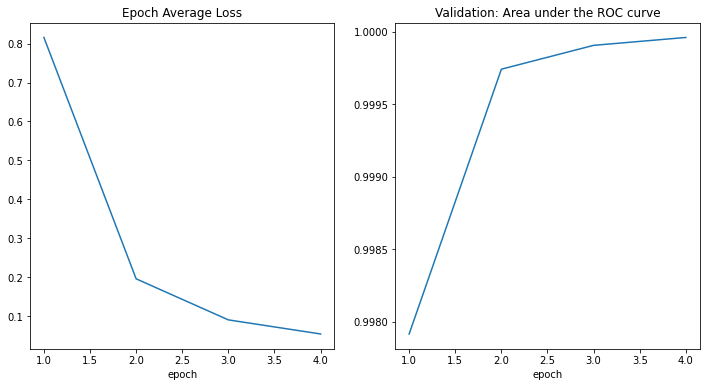

---------- epoch 1/4 (...) epoch 1 average loss: 0.7768 saved new best metric model current epoch: 1 current AUC: 0.9984 current accuracy: 0.9618 best AUC: 0.9984 at epoch: 1 ---------- epoch 2/4 (...) epoch 2 average loss: 0.1612 saved new best metric model current epoch: 2 current AUC: 0.9997 current accuracy: 0.9863 best AUC: 0.9997 at epoch: 2 ---------- epoch 3/4 (...) epoch 3 average loss: 0.0743 saved new best metric model current epoch: 3 current AUC: 0.9999 current accuracy: 0.9924 best AUC: 0.9999 at epoch: 3 ---------- epoch 4/4 (...) epoch 4 average loss: 0.0462 saved new best metric model current epoch: 4 current AUC: 1.0000 current accuracy: 0.9944 best AUC: 1.0000 at epoch: 4 train completed, best_metric: 1.0000 at epoch: 4

(...) epoch 9 average loss: 0.0094 saved new best metric model current epoch: 9 current AUC: 1.0000 current accuracy: 0.9997 best AUC: 1.0000 at epoch: 9 ---------- epoch 10/10 (...) epoch 10 average loss: 0.0080 current epoch: 10 current AUC: 1.0000 current accuracy: 0.9997 best AUC: 1.0000 at epoch: 9 train completed, best_metric: 1.0000 at epoch: 9

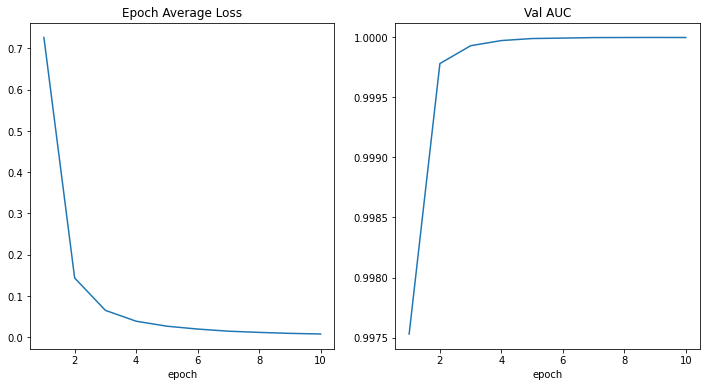

損失とメトリックをプロットする

plt.figure("train", (12, 6))

plt.subplot(1, 2, 1)

plt.title("Epoch Average Loss")

x = [i + 1 for i in range(len(epoch_loss_values))]

y = epoch_loss_values

plt.xlabel("epoch")

plt.plot(x, y)

plt.subplot(1, 2, 2)

plt.title("Val AUC")

x = [val_interval * (i + 1) for i in range(len(metric_values))]

y = metric_values

plt.xlabel("epoch")

plt.plot(x, y)

plt.show()

テストデータセット上でモデルを評価する

訓練と検証の後、検証テスト上のベストモデルを既に得ています。

モデルをテストデータセット上でそれが堅牢で over fitting していないかを確認するために評価する必要があります。

分類レポートを生成するためにこれらの予測を使用します。

model.load_state_dict(torch.load(

os.path.join(root_dir, "best_metric_model.pth")))

model.eval()

y_true = []

y_pred = []

with torch.no_grad():

for test_data in test_loader:

test_images, test_labels = (

test_data[0].to(device),

test_data[1].to(device),

)

pred = model(test_images).argmax(dim=1)

for i in range(len(pred)):

y_true.append(test_labels[i].item())

y_pred.append(pred[i].item())

print(classification_report(

y_true, y_pred, target_names=class_names, digits=4))

Note: you may need to restart the kernel to use updated packages.

precision recall f1-score support

AbdomenCT 0.9816 0.9917 0.9867 969

BreastMRI 0.9968 0.9831 0.9899 944

CXR 0.9979 0.9928 0.9954 973

ChestCT 0.9938 0.9990 0.9964 959

Hand 0.9934 0.9934 0.9934 1055

HeadCT 0.9960 0.9990 0.9975 985

accuracy 0.9932 5885

macro avg 0.9932 0.9932 0.9932 5885

weighted avg 0.9932 0.9932 0.9932 5885

precision recall f1-score support

AbdomenCT 0.9980 0.9990 0.9985 995

BreastMRI 0.9989 1.0000 0.9994 880

CXR 1.0000 0.9969 0.9985 982

ChestCT 0.9990 1.0000 0.9995 1014

Hand 0.9981 0.9990 0.9986 1048

HeadCT 1.0000 0.9990 0.9995 976

accuracy 0.9990 5895

macro avg 0.9990 0.9990 0.9990 5895

weighted avg 0.9990 0.9990 0.9990 5895

データディレクトリのクリーンアップ

一時ディレクトリが使用された場合ディレクトリを削除します。

if directory is None:

shutil.rmtree(root_dir)

以上

MONAI 1.0 : PyTorch ユーザのための MONAI

MONAI 1.0 : PyTorch ユーザのための MONAI (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 11/01/2022 (1.0.1)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

- 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション

- sales-info@classcat.com ; Web: www.classcat.com ; ClassCatJP

MONAI 1.0 : PyTorch ユーザのための MONAI

このチュートリアルは MONAI API を簡単に紹介してその柔軟性と使い易さにハイライトを当てます。それは PyTorch の基本的な理解を前提とし、MONAI がヘルスケア画像処理における深層学習用にドメインに最適化された機能を提供する方法を示します。

パッケージのインストール

MONAI のコア機能は Python で書かれていて Numpy と Pytorch にのみ依存しています。

このセクションは MONAI の最新版をインストールしてインストールを検証します。

# install the latest weekly preview version of MONAI

%pip install -q "monai-weekly[tqdm, nibabel, gdown, ignite]"

import warnings

warnings.filterwarnings("ignore") # remove some scikit-image warnings

import monai

monai.config.print_config()

MONAI version: 0.10.dev2237

Numpy version: 1.21.6

Pytorch version: 1.12.1+cu113

MONAI flags: HAS_EXT = False, USE_COMPILED = False, USE_META_DICT = False

MONAI rev id: 533b9b8f56542f7cbca718e062271fd976c267c1

MONAI __file__: /usr/local/lib/python3.7/dist-packages/monai/__init__.py

Optional dependencies:

Pytorch Ignite version: 0.4.10

Nibabel version: 3.0.2

scikit-image version: 0.18.3

Pillow version: 7.1.2

Tensorboard version: 2.8.0

gdown version: 4.4.0

TorchVision version: 0.13.1+cu113

tqdm version: 4.64.1

lmdb version: 0.99

psutil version: 5.4.8

pandas version: 1.3.5

einops version: NOT INSTALLED or UNKNOWN VERSION.

transformers version: NOT INSTALLED or UNKNOWN VERSION.

mlflow version: NOT INSTALLED or UNKNOWN VERSION.

pynrrd version: NOT INSTALLED or UNKNOWN VERSION.

For details about installing the optional dependencies, please visit:

https://docs.monai.io/en/latest/installation.html#installing-the-recommended-dependencies

数行のコードでパブリックな医用画像データセットへアクセス

公開されているベンチマークの使用はオープンで再現性のある研究のために重要です。MONAI は良く知られた公開データセットへの素早いアクセスを提供することを目的としています。このセクションは医療セグメンテーション・デカスロン (= Medical Segmentation Decathlon ) のデータセットから始めます。

DecathlonDataset オブジェクトは torch.data.utils.Dataset の薄いラッパーです。それは __getitem__ と __len__ を実装していて、PyTorch の組込みデータローダ torch.data.utils.DataLoader と完全に互換です。

PyTorch データセット API と比較して、DecathlonDataset は以下の追加機能を持ちます :

- 自動的なデータのダウンロードと解凍

- データと前処理の中間結果のキャッシング

- 訓練、検証とテストのランダムな分割

from monai.apps import DecathlonDataset

dataset = DecathlonDataset(root_dir="./", task="Task05_Prostate", section="training", transform=None, download=True)

print(f"\nnumber of subjects: {len(dataset)}.\nThe first element in the dataset is {dataset[0]}.")

2022-09-16 06:55:41,150 - INFO - Verified 'Task05_Prostate.tar', md5: 35138f08b1efaef89d7424d2bcc928db.

2022-09-16 06:55:41,152 - INFO - File exists: Task05_Prostate.tar, skipped downloading.

2022-09-16 06:55:41,156 - INFO - Non-empty folder exists in Task05_Prostate, skipped extracting.

Loading dataset: 100%|██████████| 26/26 [00:00<00:00, 186095.40it/s]

number of subjects: 26.

The first element in the dataset is {'image': 'Task05_Prostate/imagesTr/prostate_46.nii.gz', 'label': 'Task05_Prostate/labelsTr/prostate_46.nii.gz'}.

コードセクションは公開レポジトリから "Task05_Prostate.tar" (download=True) をダウンロードして、それを解凍し、そしてアーカイブにより提供される JSON ファイルを解析することにより DecathlonDataset を作成しました。

これは前立腺 (= prostate) 移行 (= transitional) ゾーンと周辺 (= peripheral) ゾーンの輪郭を描く (= delineate) ための 3 クラス・セグメンテーション・タスクです (背景, TZ, PZ クラス)。入力は 2 つの様式、つまり T2 と ADC MRI を持ちます。

len(dataset) と dataset[0] は、それぞれデータセットのサイズを問い合わせ、データセットの最初の要素を取り出します。データセットのためのどのような画像変換も指定していませんので、この iterable なデータセットの出力は画像とセグメンテーション・ファイル名の単なるペアです。

柔軟な画像データ変換

このセクションはファイル名をメモリ内のデータ配列に変換する MONAI 変換を導入します、これにより深層学習モデルにより消費される準備ができます。前処理パイプラインのより多くのサンプルは tutorial レポジトリ と 開発者ガイド で利用可能です。ここでは画像前処理の主要な機能を簡単にカバーします。

配列 vs 辞書ベースの変換

配列変換は MONAI の基本的なビルディングブロックで、それは torchvision.transforms と同様な単純な callable です。2 つの違いがあります :

- MONAI 変換は医用画像特有の処理機能を実装しています。

- MONAI 変換は入力が numpy 配列、pytorch テンソルかテンソル like なオブジェクトであることを前提としています。

以下はローダー変換を開始します、これはファイル名文字列を実際の画像データに変換します。

この変換への より多くのオプションについてのドキュメント を参照してください。

from monai.transforms import LoadImage

loader = LoadImage(image_only=True)

img_array = loader("Task05_Prostate/imagesTr/prostate_02.nii.gz")

print(img_array.shape)

(320, 320, 24, 2)

辞書変換は配列バージョンのラッパーに過ぎません。配列ベースのものと比べて、同じ種類の演算やステートメントを複数のデータ入力に適用することがより簡単です。

以下のセクションは画像とセグメンテーション・マスクのペアを読みます、変換が辞書のどの項目が処理されるべきかを知れるようにキーが指定される必要があることに注意してください。

from monai.transforms import LoadImageD

dict_loader = LoadImageD(keys=("image", "label"))

data_dict = dict_loader({"image": "Task05_Prostate/imagesTr/prostate_02.nii.gz",

"label": "Task05_Prostate/labelsTr/prostate_02.nii.gz"})

print(f"image shape: {data_dict['image'].shape}, \nlabel shape: {data_dict['label'].shape}")

image shape: (320, 320, 24, 2), label shape: (320, 320, 24)

変換の構成

多くの場合、変換のチェインを構築して、前処理パラメータを調整して、高速な前処理パイプラインを作成することは有益です。monai.transforms.Compose はこれらのユースケースのために設計されています。

以下のコードは複数の前処理ステップを行なうために変換チェインを開始しています :

- Nifti 画像を (画像メタデータ情報と共に) ロードします

- 画像とラベルの両方をチャネル first にする (画像を reshape してラベルのためにチャネル次元を追加します)

- 画像とラベルを 1 mm 四方にする

- 画像とラベルの両方を "RAS" 座標系にあるようにする

- 画像強度をスケールする

- 画像とラベルを空間サイズ (64, 64, 32) mm にリサイズする

- 画像をランダムに回転とスケールしますが、出力サイズは (64, 64, 32) mm に保持します。

- 画像とラベルを torch テンソルに変換する

import numpy as np

from monai.transforms import \

LoadImageD, EnsureChannelFirstD, AddChannelD, ScaleIntensityD, ToTensorD, Compose, \

AsDiscreteD, SpacingD, OrientationD, ResizeD, RandAffineD

KEYS = ("image", "label")

xform = Compose([

LoadImageD(KEYS),

EnsureChannelFirstD("image"),

AddChannelD("label"),

OrientationD(KEYS, axcodes='RAS'),

SpacingD(KEYS, pixdim=(1., 1., 1.), mode=('bilinear', 'nearest')),

ScaleIntensityD(keys="image"),

ResizeD(KEYS, (64, 64, 32), mode=('trilinear', 'nearest')),

RandAffineD(KEYS, spatial_size=(-1, -1, -1),

rotate_range=(0, 0, np.pi/2),

scale_range=(0.1, 0.1),

mode=('bilinear', 'nearest'),

prob=1.0),

ToTensorD(KEYS),

])

data_dict = xform({"image": "Task05_Prostate/imagesTr/prostate_02.nii.gz",

"label": "Task05_Prostate/labelsTr/prostate_02.nii.gz"})

print(data_dict["image"].shape, data_dict["label"].shape)

(2, 64, 64, 32) (1, 64, 64, 32)

MONAI には有用な変換のセットがあり、今後更に増えます。詳細は https://docs.monai.io/en/latest/transforms.html を見てください。

データセット、変換とデータローダ

私達が持っているものをまとめると :

- Dataset : torch.utils.data.Dataset の薄いラッパー

- Transform : callable、Compose により作成される変換チェインの一部です。

- データセットへの変換のセッティングはデータロードと前処理パイプラインを可能にします。

パイプラインは pytorch ネイティブのデータローダと連携できて、これはマルチプロセッシングのサポートと柔軟なバッチサンプリング・スキームを提供します。

けれども、MONAI データローダ monai.data.DataLoader と連携することが推奨されます、これは pytorch ネイティブのラッパーです。MONAI データローダは以下の機能を主として追加します :

- マルチプロセスのコンテキストでランダム化された増強を正しく処理します。

- マルチサンプルデータのリストを個々の訓練サンプルに平坦化するためのカスタマイズされた collate 関数

DecathlonDataset の初期化は (非ランダム化) 変換結果のキャッシングを含みます。それは遅いかもしれません、複数エポックの訓練のために初期化されたオブジェクトを使用するとき、遥かに改良された速度のために空間を効果的にトレードオフします。

import torch

from monai.data import DataLoader

# start a chain of transforms

xform = Compose([

LoadImageD(KEYS),

EnsureChannelFirstD("image"),

AddChannelD("label"),

OrientationD(KEYS, axcodes='RAS'),

SpacingD(KEYS, pixdim=(1., 1., 1.), mode=('bilinear', 'nearest')),

ScaleIntensityD(keys="image"),

ResizeD(KEYS, (64, 64, 32), mode=('trilinear', 'nearest')),

RandAffineD(KEYS, spatial_size=(-1, -1, -1),

rotate_range=(0, 0, np.pi/2),

scale_range=(0.1, 0.1),

mode=('bilinear', 'nearest'),

prob=1.0),

ToTensorD(KEYS),

])

# start a dataset

dataset = DecathlonDataset(root_dir="./", task="Task05_Prostate", section="training", transform=xform, download=True)

# start a pytorch dataloader

# data_loader = torch.utils.data.DataLoader(dataset, batch_size=1, shuffle=False, num_workers=1)

data_loader = DataLoader(dataset, batch_size=1, shuffle=True, num_workers=1)

2022-09-16 06:55:43,240 - INFO - Verified 'Task05_Prostate.tar', md5: 35138f08b1efaef89d7424d2bcc928db. 2022-09-16 06:55:43,241 - INFO - File exists: Task05_Prostate.tar, skipped downloading. 2022-09-16 06:55:43,246 - INFO - Non-empty folder exists in Task05_Prostate, skipped extracting. Loading dataset: 100%|██████████| 26/26 [00:21<00:00, 1.20it/s]

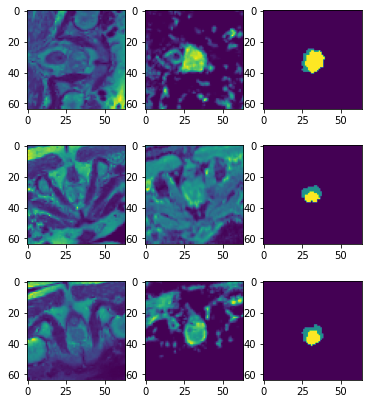

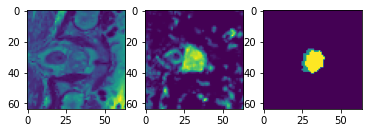

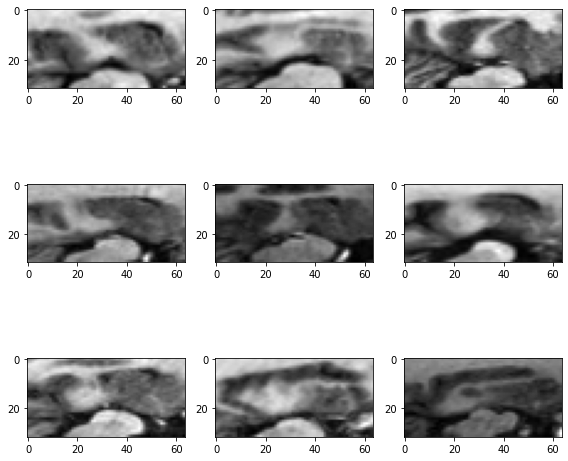

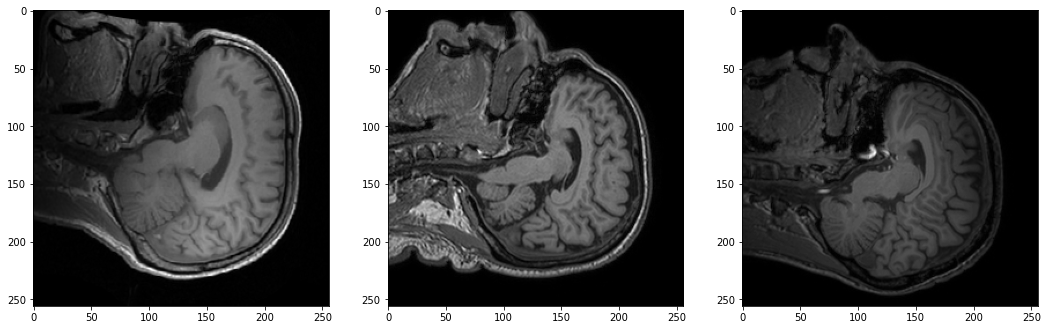

data_dict で何が起きているか覗いてみましょう (以下のセクションの再実行はデータセットからランダムに増強されたサンプルを生成します) :

import matplotlib.pyplot as plt

import numpy as np

data_dict = next(iter(data_loader))

print(data_dict["image"].shape, data_dict["label"].shape, data_dict["image_meta_dict"]["filename_or_obj"])

plt.subplots(1, 3)

plt.subplot(1, 3, 1); plt.imshow(data_dict["image"][0, 0, ..., 16])

plt.subplot(1, 3, 2); plt.imshow(data_dict["image"][0, 1, ..., 16])

plt.subplot(1, 3, 3); plt.imshow(data_dict["label"][0, 0, ..., 16])

plt.show()

print(f"unique labels: {np.unique(data_dict['label'])}")

(1, 2, 64, 64, 32) (1, 1, 64, 64, 32) ['Task05_Prostate/imagesTr/prostate_25.nii.gz']

データローダは、深層学習モデルに対応できるように、画像とラベルの両方にバッチ次元を追加しました。

ラベルのために "nearest" 補完モードが使用されますので、変換中に一意のクラスの数が保持されます。

層、ブロック、ネットワークと損失関数

データ入力パイプラインを通り抜けました。適切に前処理されたデータは、2 つの様式の入力を使用して 3 クラス・セグメンテーション・タスクのための準備ができました。

このセクションは UNet モデル、そして損失関数と optimzer を作成します。

これら総てのモジュールは (torch.nn.Module のような) PyTorch インターフェイスの直接的な使用か拡張です。それらは、コードが標準 PyTorch API に従うのであれば、任意のカスタマイズされた Python コードで置き換え可能です。

MONAI のモジュールは医用画像解析のために拡張モジュールを提供することに焦点を当てています :

- 柔軟性とコード可読性の両者を目的とした参照ネットワークの実装

- 1D, 2D と 3D ネットワークと互換な事前定義された層とブロック

- ドメイン固有の損失関数

from monai.networks.nets import UNet

from monai.networks.layers import Norm

from monai.losses import DiceLoss

device = torch.device('cuda:0')

net = UNet(dimensions=3, in_channels=2, out_channels=3, channels=(16, 32, 64, 128, 256),

strides=(2, 2, 2, 2), num_res_units=2, norm=Norm.BATCH).to(device)

loss = DiceLoss(to_onehot_y=True, softmax=True)

opt = torch.optim.Adam(net.parameters(), 1e-2)

UNet は dimensions パラメータで定義されます。それは Conv1d, Conv2d と Conv3d のような、pytorch API の空間次元の数を指定します。同じ実装で、1D, 2D, 3D とマルチモーダル訓練のために容易に構成できます。

torch.nn.Module の拡張としての UNet は特定の方法で体系化された MONAI ブロックと層のセットです。ブロックと層は、"Conv. + Feature Norm. + Activation" のような一般に使用される組合せのように、再利用可能なサブモジュールとして設計されています。

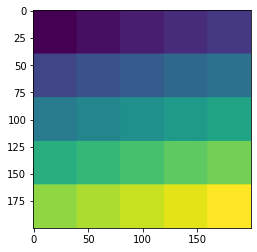

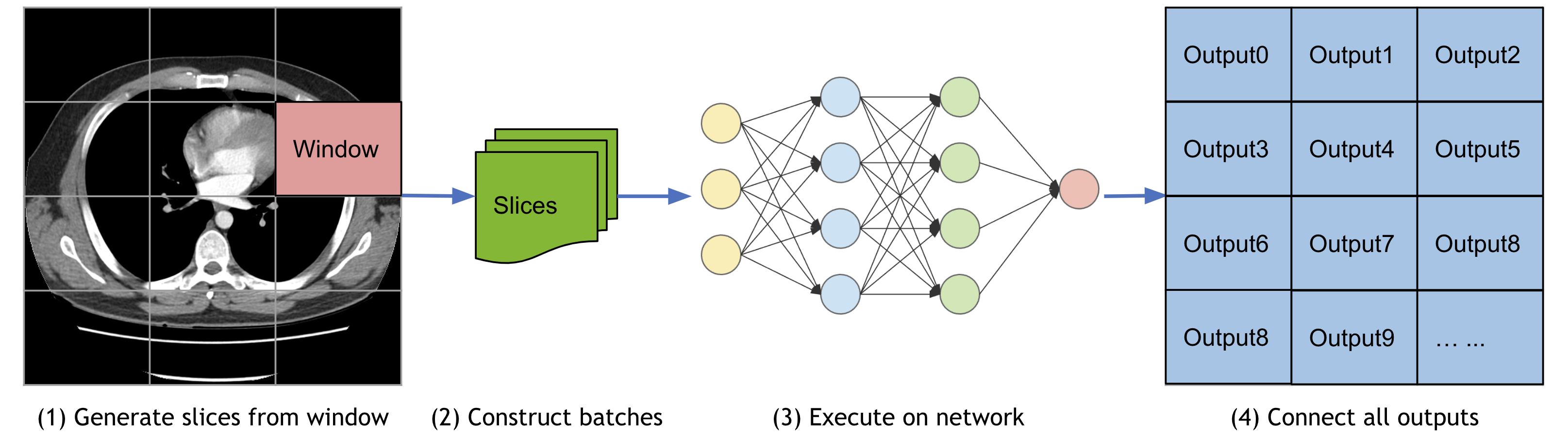

スライディング・ウィンドウ推論

この一般に使用されるモジュールについて、MONAI は単純な PyTorch ベースの実装を提供します、これはウィンドウサイズと入力モデル (これは torch.nn.Module 実装であり得ます) の仕様だけを必要とします。

以下のデモは、総ての空間位置を通して実行される (40, 40) 空間サイズ・ウィンドウを集約することにより、(1, 1, 200, 200) の入力画像上のスライディング・ウィンドウ推論の toy を示します。

roi_size, sw_batch_size と overlap パラメータをそれらのスライディング・ウィンドウ出力上のインパクトを見るために変更することができます。

from monai.inferers import SlidingWindowInferer

class ToyModel:

# A simple model generates the output by adding an integer `pred` to input.

# each call of this instance increases the integer by 1.

pred = 0

def __call__(self, input):

self.pred = self.pred + 1

input = input + self.pred

return input

infer = SlidingWindowInferer(roi_size=(40, 40), sw_batch_size=1, overlap=0)

input_tensor = torch.zeros(1, 1, 200, 200)

output_tensor = infer(input_tensor, ToyModel())

plt.imshow(output_tensor[0, 0]); plt.show()

訓練ワークフローの開始 (エポック毎に検証)

入力パイプライン、ネットワーク・アーキテクチャ、損失関数は総て既存の pytorch ベースのワークフローと互換です。様々なユースケースについてはチュートリアルを参照してください : https://github.com/Project-MONAI/tutorials

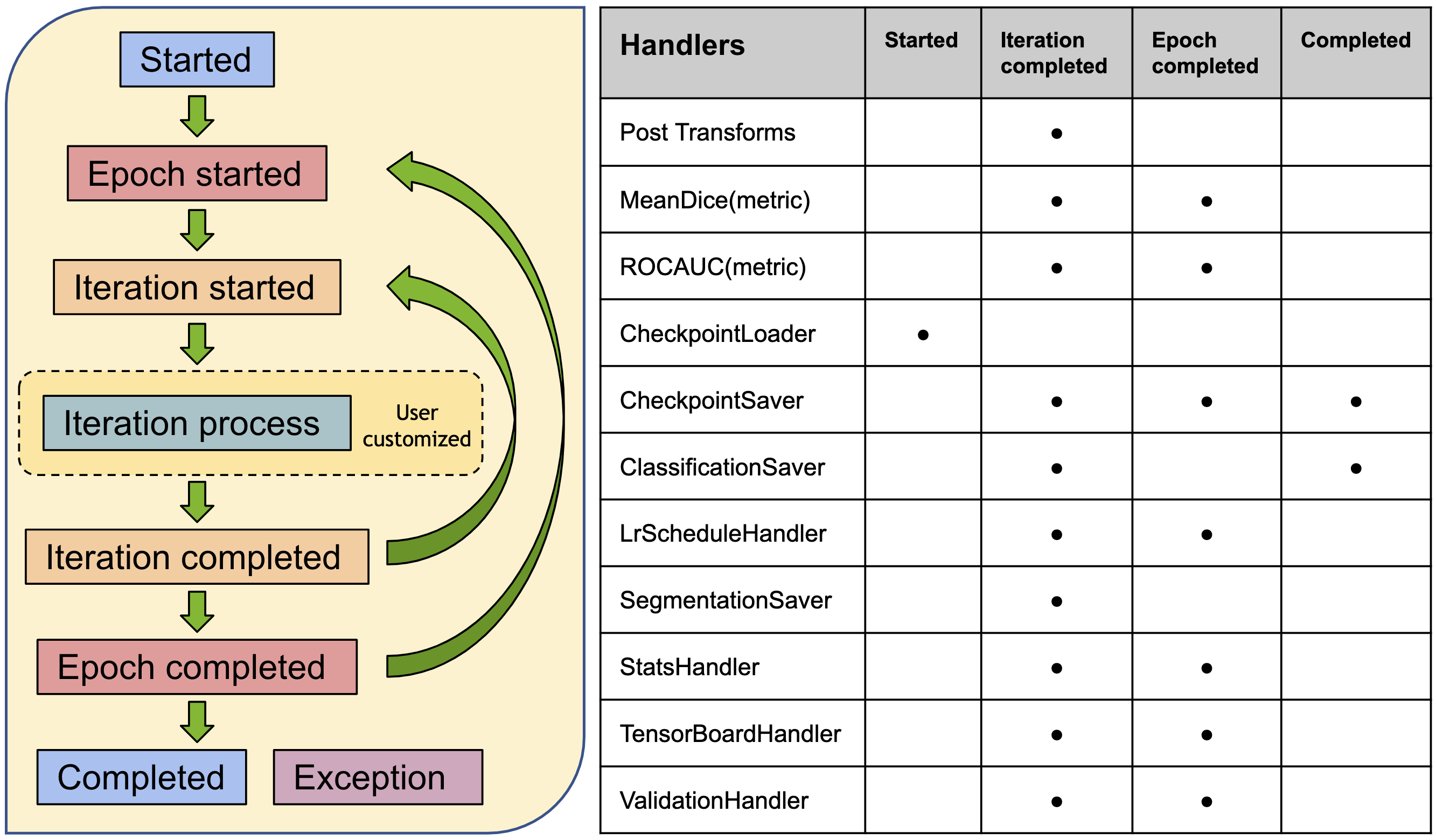

ここで PyTorch-Ignite ベースで MONAI により構築された、ワークフロー・ユティリティにハイライトを当てたいです。主要な目標は、比較的標準的な訓練ワークフローを構築する際にユーザの労力を軽減することです。

import ignite

print(ignite.__version__)

0.4.10

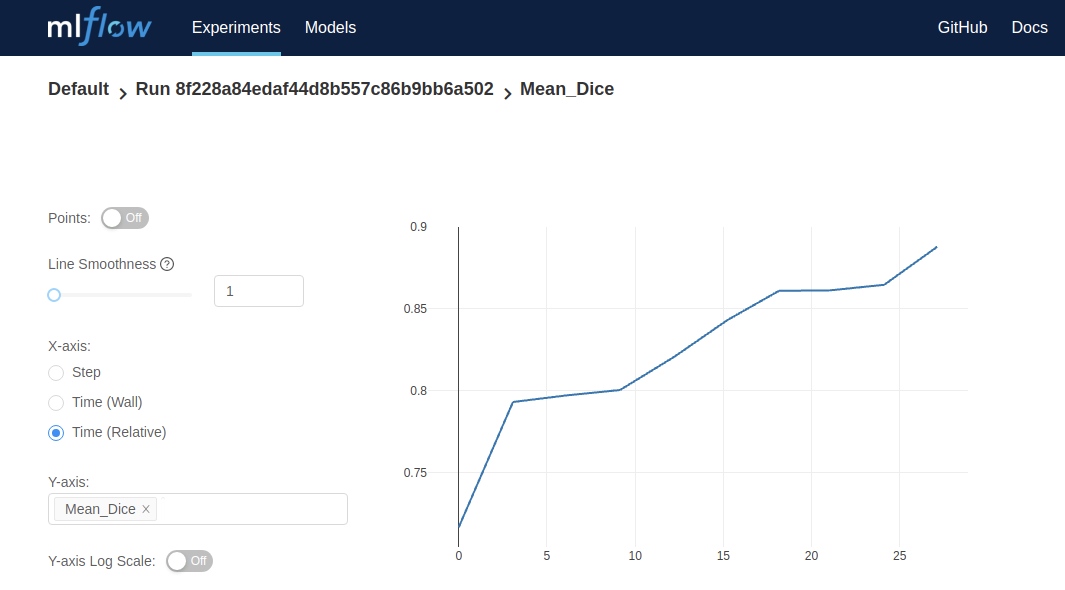

以下のコマンドは SupervisedTrainer インスタンスを起動します。PyTorch ignite の機能の拡張として、それは前述した総ての要素を結合します。trainer.run() の呼び出しは 2 エポックの間ネットワークを訓練して、総てのエポックの最後に訓練データに基づいて MeadDice メトリックを計算します。

key_train_metric はモデルの品質向上の進捗を追跡するために使用されます。追加のハンドラが早期停止と学習率スケジューリングを行なうために設定できます。

StatsHandler は診断情報を stdout にプリントするために訓練反復毎にトリガーされます。これらはユーザ指定の頻度で詳細な訓練ログを生成するように構成できます。

イベント処理システムの詳細は、ドキュメント https://docs.monai.io/en/latest/handlers.html を参照してください。

注目すべき点は、これらの機能は通常の訓練と検証パイプラインの高速なプロトタイピングを容易にすることです。ユーザは前のセクションで述べたモジュールを利用して、独自のパイプラインを構築することを常に選択できます。

from monai.engines import SupervisedTrainer

from monai.inferers import SlidingWindowInferer

from monai.handlers import StatsHandler, MeanDice, from_engine

from monai.transforms import AsDiscreteD

import sys

import logging

logging.basicConfig(stream=sys.stdout, level=logging.INFO)

trainer = SupervisedTrainer(

device=device,

max_epochs=2,

train_data_loader=data_loader,

network=net,

optimizer=opt,

loss_function=loss,

inferer=SlidingWindowInferer((32, 32, -1), sw_batch_size=2),

postprocessing=AsDiscreteD(keys=["pred", "label"], argmax=(True, False), to_onehot=3),

key_train_metric={"train_meandice": MeanDice(output_transform=from_engine(["pred", "label"]))},

train_handlers=StatsHandler(tag_name="train_loss", output_transform=from_engine(["loss"], first=True)),

)

trainer.run()

INFO:ignite.engine.engine.SupervisedTrainer:Engine run resuming from iteration 0, epoch 0 until 2 epochs INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 1/26 -- train_loss: 0.8139 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 2/26 -- train_loss: 0.7707 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 3/26 -- train_loss: 0.6901 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 4/26 -- train_loss: 0.6979 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 5/26 -- train_loss: 0.7192 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 6/26 -- train_loss: 0.6859 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 7/26 -- train_loss: 0.6445 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 8/26 -- train_loss: 0.6273 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 9/26 -- train_loss: 0.6346 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 10/26 -- train_loss: 0.6078 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 11/26 -- train_loss: 0.5424 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 12/26 -- train_loss: 0.5851 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 13/26 -- train_loss: 0.5647 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 14/26 -- train_loss: 0.5551 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 15/26 -- train_loss: 0.5925 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 16/26 -- train_loss: 0.5389 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 17/26 -- train_loss: 0.5662 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 18/26 -- train_loss: 0.6309 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 19/26 -- train_loss: 0.6168 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 20/26 -- train_loss: 0.5556 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 21/26 -- train_loss: 0.5243 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 22/26 -- train_loss: 0.5801 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 23/26 -- train_loss: 0.5132 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 24/26 -- train_loss: 0.4951 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 25/26 -- train_loss: 0.4870 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 1/2, Iter: 26/26 -- train_loss: 0.5108 INFO:ignite.engine.engine.SupervisedTrainer:Got new best metric of train_meandice: 0.4181462824344635 INFO:ignite.engine.engine.SupervisedTrainer:Epoch[1] Metrics -- train_meandice: 0.4181 INFO:ignite.engine.engine.SupervisedTrainer:Key metric: train_meandice best value: 0.4181462824344635 at epoch: 1 INFO:ignite.engine.engine.SupervisedTrainer:Epoch[1] Complete. Time taken: 00:00:08 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 1/26 -- train_loss: 0.5620 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 2/26 -- train_loss: 0.5373 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 3/26 -- train_loss: 0.4764 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 4/26 -- train_loss: 0.5111 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 5/26 -- train_loss: 0.5922 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 6/26 -- train_loss: 0.5519 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 7/26 -- train_loss: 0.6246 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 8/26 -- train_loss: 0.4363 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 9/26 -- train_loss: 0.5052 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 10/26 -- train_loss: 0.5900 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 11/26 -- train_loss: 0.5997 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 12/26 -- train_loss: 0.4996 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 13/26 -- train_loss: 0.4969 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 14/26 -- train_loss: 0.5740 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 15/26 -- train_loss: 0.5852 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 16/26 -- train_loss: 0.5460 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 17/26 -- train_loss: 0.5034 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 18/26 -- train_loss: 0.5233 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 19/26 -- train_loss: 0.5109 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 20/26 -- train_loss: 0.4877 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 21/26 -- train_loss: 0.5745 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 22/26 -- train_loss: 0.5044 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 23/26 -- train_loss: 0.4623 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 24/26 -- train_loss: 0.4399 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 25/26 -- train_loss: 0.4553 INFO:ignite.engine.engine.SupervisedTrainer:Epoch: 2/2, Iter: 26/26 -- train_loss: 0.5245 INFO:ignite.engine.engine.SupervisedTrainer:Got new best metric of train_meandice: 0.4688393473625183 INFO:ignite.engine.engine.SupervisedTrainer:Epoch[2] Metrics -- train_meandice: 0.4688 INFO:ignite.engine.engine.SupervisedTrainer:Key metric: train_meandice best value: 0.4688393473625183 at epoch: 2 INFO:ignite.engine.engine.SupervisedTrainer:Epoch[2] Complete. Time taken: 00:00:08 INFO:ignite.engine.engine.SupervisedTrainer:Engine run complete. Time taken: 00:00:16

決定論的訓練

決定論的訓練サポートは再現可能な研究のために重要です。MONAI は現在 2 つのメカニズムを提供しています :

- 総てのランダム変換のランダム状態を設定します。これはグローバルなランダム状態には影響しません。例えば :

# define a transform chain for pre-processing train_transforms = monai.transforms.Compose([ LoadImaged(keys=['image', 'label']), RandRotate90d(keys=['image', 'label'], prob=0.2, spatial_axes=[0, 2]), ... ... ]) # set determinism for reproducibility train_transforms.set_random_state(seed=0) - 1 行のコードでグローバルに python, numpy と pytorch のための決定論的訓練を有効にします、例えば :

monai.utils.set_determinism(seed=0, additional_settings=None)

まとめ

MONAI の主要なモジュールを通り抜けてきました。高度に柔軟な拡張とラッパーを作成することにより、MONAI は医用画像解析の観点から pytorch API を強化しています。

以下のような、この短いチュートリアルではカバーされなかったソフトウェア機能があります :

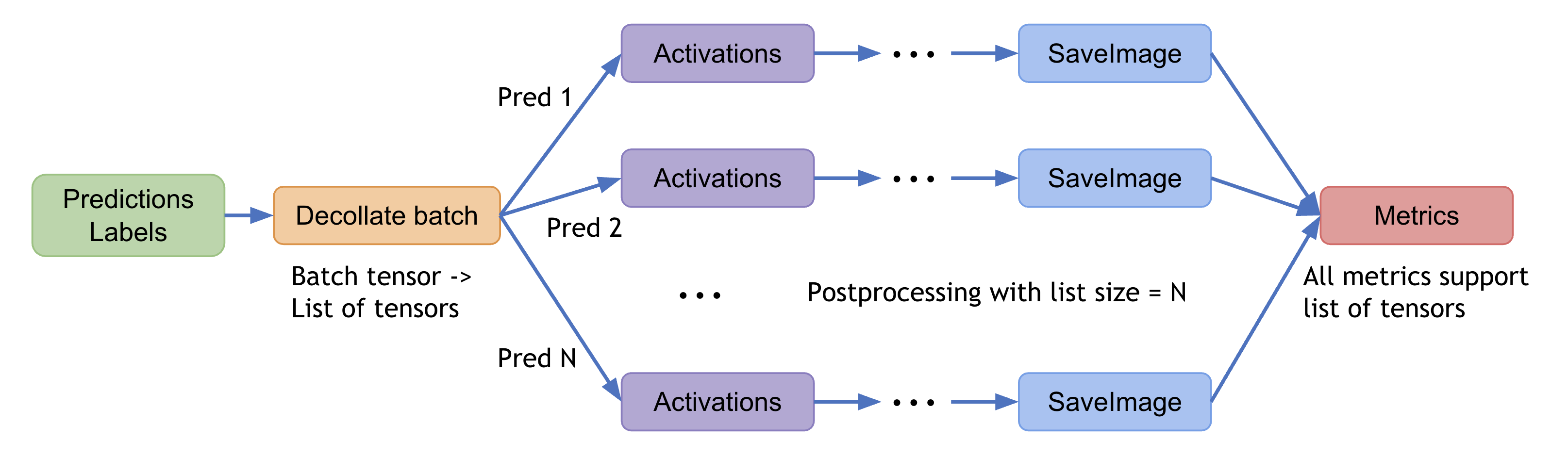

- 後処理変換

- 視覚化インターフェイス

- サードパーティの医用画像ツールキットからの組み込めるデータ変換

- 他の人気のある深層学習フレームワークを使用するワークフローの構築

- MONAI 研究

最新のマイルストーンのハイライトの詳細については、https://docs.monai.io/en/latest/highlights.html にアクセスしてください。

MONAI を深く理解するには、examples レポジトリは良い開始点です : https://github.com/Project-MONAI/tutorials

API ドキュメントについては、https://docs.monai.io にアクセスしてください。

以上

MONAI 1.0 : MedNIST デモ (画像分類チュートリアル)

MONAI 1.0 : MedNIST デモ (画像分類チュートリアル) (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 10/30/2022 (1.0.1)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

- 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション

- sales-info@classcat.com ; Web: www.classcat.com ; ClassCatJP

MONAI 1.0 : MedNIST デモ (画像分類チュートリアル)

イントロダクション

このチュートリアルでは、MedNIST データセットに基づいて end-to-end な訓練と評価サンプルを紹介します。以下のステップを通り抜けます :

- 訓練とテストのための MONAI データセットを作成します。

- データの前処理のために MONAI 変換を使用します。

- 分類タスクのために MONAI から DenseNet を使用します。

- PyTorch プログラムでモデルを訓練します。

- テストデータセットで評価します。

データセットの取得

MedNIST データセットは TCIA, RSNA Bone Age チャレンジ と NIH Chest X-ray データセット の様々なセットから集められました。

データセットは Dr. Bradley J. Erickson M.D., Ph.D. (Department of Radiology, Mayo Clinic) のお陰により Creative Commons CC BY-SA 4.0 ライセンス のもとで利用可能になっています。MedNIST データセットを使用する場合、出典を明示してください、e.g. https://github.com/Project-MONAI/tutorials/blob/master/2d_classification/mednist_tutorial.ipynb。

以下のコマンドはデータセット (~ 60MB) をダウンロードして unzip します。

!wget -q https://www.dropbox.com/s/5wwskxctvcxiuea/MedNIST.tar.gz

# unzip the '.tar.gz' file to the current directory

import tarfile

datafile = tarfile.open("MedNIST.tar.gz")

datafile.extractall()

datafile.close()

MONAI をインストールします :

!pip install -q "monai-weekly[gdown, nibabel, tqdm, itk]"

import os

import shutil

import tempfile

import matplotlib.pyplot as plt

from PIL import Image

import torch

import numpy as np

from sklearn.metrics import classification_report

from monai.apps import download_and_extract

from monai.config import print_config

from monai.metrics import ROCAUCMetric

from monai.networks.nets import DenseNet121

from monai.transforms import (

Activations,

EnsureChannelFirst,

AsDiscrete,

Compose,

LoadImage,

RandFlip,

RandRotate,

RandZoom,

ScaleIntensity,

ToTensor,

)

from monai.data import Dataset, DataLoader

from monai.utils import set_determinism

print_config()

MONAI version: 1.1.dev2238

Numpy version: 1.21.6

Pytorch version: 1.12.1+cu113

MONAI flags: HAS_EXT = False, USE_COMPILED = False, USE_META_DICT = False

MONAI rev id: 8d72c2b845c8e91aad9a7cf17f2049bdec215f9d

MONAI __file__: /usr/local/lib/python3.7/dist-packages/monai/__init__.py

Optional dependencies:

Pytorch Ignite version: NOT INSTALLED or UNKNOWN VERSION.

Nibabel version: 3.0.2

scikit-image version: 0.18.3

Pillow version: 7.1.2

Tensorboard version: 2.8.0

gdown version: 4.4.0

TorchVision version: 0.13.1+cu113

tqdm version: 4.64.1

lmdb version: 0.99

psutil version: 5.4.8

pandas version: 1.3.5

einops version: NOT INSTALLED or UNKNOWN VERSION.

transformers version: NOT INSTALLED or UNKNOWN VERSION.

mlflow version: NOT INSTALLED or UNKNOWN VERSION.

pynrrd version: NOT INSTALLED or UNKNOWN VERSION.

For details about installing the optional dependencies, please visit:

https://docs.monai.io/en/latest/installation.html#installing-the-recommended-dependencies

データセットフォルダから画像ファイル名を読む

最初に、データセットファイルを確認して幾つかの統計情報を示します。データセットには 6 つのフォルダがあります : Hand, AbdomenCT, CXR, ChestCT, BreastMRI, HeadCT, これらは分類モデルを訓練するラベルとして使用されるべきです。

data_dir = './MedNIST/'

class_names = sorted([x for x in os.listdir(data_dir) if os.path.isdir(os.path.join(data_dir, x))])

num_class = len(class_names)

image_files = [[os.path.join(data_dir, class_name, x)

for x in os.listdir(os.path.join(data_dir, class_name))]

for class_name in class_names]

image_file_list = []

image_label_list = []

for i, class_name in enumerate(class_names):

image_file_list.extend(image_files[i])

image_label_list.extend([i] * len(image_files[i]))

num_total = len(image_label_list)

image_width, image_height = Image.open(image_file_list[0]).size

print('Total image count:', num_total)

print("Image dimensions:", image_width, "x", image_height)

print("Label names:", class_names)

print("Label counts:", [len(image_files[i]) for i in range(num_class)])

Total image count: 58954 Image dimensions: 64 x 64 Label names: ['AbdomenCT', 'BreastMRI', 'CXR', 'ChestCT', 'Hand', 'HeadCT'] Label counts: [10000, 8954, 10000, 10000, 10000, 10000]

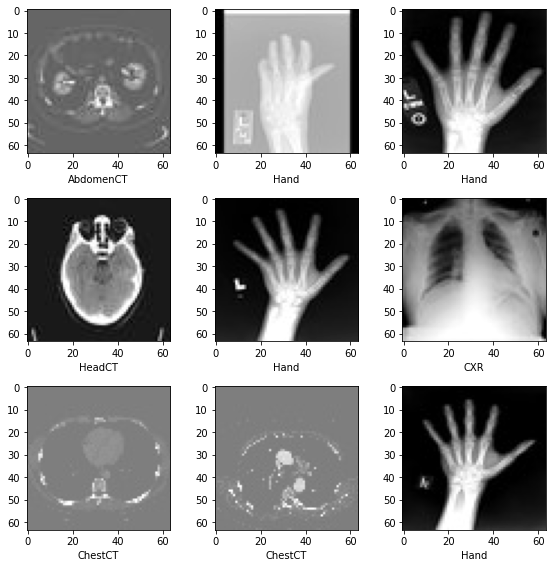

データセットからランダムに選択された幾つかのサンプルを可視化する

plt.subplots(3, 3, figsize=(8, 8))

for i,k in enumerate(np.random.randint(num_total, size=9)):

im = Image.open(image_file_list[k])

arr = np.array(im)

plt.subplot(3, 3, i + 1)

plt.xlabel(class_names[image_label_list[k]])

plt.imshow(arr, cmap='gray', vmin=0, vmax=255)

plt.tight_layout()

plt.show()

訓練、検証とテストデータ・リストの準備

データセットの 10% を検証用に、10% をテスト用にランダムに選択します。

valid_frac, test_frac = 0.1, 0.1

trainX, trainY = [], []

valX, valY = [], []

testX, testY = [], []

for i in range(num_total):

rann = np.random.random()

if rann < valid_frac:

valX.append(image_file_list[i])

valY.append(image_label_list[i])

elif rann < test_frac + valid_frac:

testX.append(image_file_list[i])

testY.append(image_label_list[i])

else:

trainX.append(image_file_list[i])

trainY.append(image_label_list[i])

print("Training count =",len(trainX),"Validation count =", len(valX), "Test count =",len(testX))

Training count = 47197 Validation count = 5900 Test count = 5857

データを前処理するために MONAI 変換, Dataset と Dataloader を定義する

train_transforms = Compose([

LoadImage(image_only=True),

EnsureChannelFirst(),

ScaleIntensity(),

RandRotate(range_x=15, prob=0.5, keep_size=True),

RandFlip(spatial_axis=0, prob=0.5),

RandZoom(min_zoom=0.9, max_zoom=1.1, prob=0.5, keep_size=True),

ToTensor()

])

val_transforms = Compose([

LoadImage(image_only=True),

EnsureChannelFirst(),

ScaleIntensity(),

ToTensor()

])

act = Activations(softmax=True)

to_onehot = AsDiscrete(to_onehot=num_class)

class MedNISTDataset(Dataset):

def __init__(self, image_files, labels, transforms):

self.image_files = image_files

self.labels = labels

self.transforms = transforms

def __len__(self):

return len(self.image_files)

def __getitem__(self, index):

return self.transforms(self.image_files[index]), self.labels[index]

train_ds = MedNISTDataset(trainX, trainY, train_transforms)

train_loader = DataLoader(train_ds, batch_size=300, shuffle=True, num_workers=2)

val_ds = MedNISTDataset(valX, valY, val_transforms)

val_loader = DataLoader(val_ds, batch_size=300, num_workers=2)

test_ds = MedNISTDataset(testX, testY, val_transforms)

test_loader = DataLoader(test_ds, batch_size=300, num_workers=2)

ネットワークと optimizer の定義

- バッチ毎にモデルをどの位更新するか学習率を設定します。

- 総エポック数を設定します、シャッフルとランダム変換を持ちますので、総てのエポックの訓練データは異なります。そしてこれは単なる get start チュートリアルですから、4 エポックだけ訓練しましょう。10 エポック訓練すれば、モデルはテストデータセットで 100% 精度を達成できます。

- MONAI から DenseNet を使用して GPU デバイスに移します、この DenseNet は 2D と 3D 分類タスクの両方をサポートできます。

- Adam optimizer を使用します。

device = torch.device("cuda:0")

model = DenseNet121(

spatial_dims=2,

in_channels=1,

out_channels=num_class

).to(device)

loss_function = torch.nn.CrossEntropyLoss()

optimizer = torch.optim.Adam(model.parameters(), 1e-5)

epoch_num = 4

val_interval = 1

モデル訓練

エポックループとステップループを実行する典型的な PyTorch 訓練を実行し、そしてエポック毎後に検証を行ないます。ベストな検証精度を得た場合にはモデル重みをファイルにセーブします。

best_metric = -1

best_metric_epoch = -1

epoch_loss_values = list()

auc_metric = ROCAUCMetric()

metric_values = list()

for epoch in range(epoch_num):

print('-' * 10)

print(f"epoch {epoch + 1}/{epoch_num}")

model.train()

epoch_loss = 0

step = 0

for batch_data in train_loader:

step += 1

inputs, labels = batch_data[0].to(device), batch_data[1].to(device)

optimizer.zero_grad()

outputs = model(inputs)

loss = loss_function(outputs, labels)

loss.backward()

optimizer.step()

epoch_loss += loss.item()

print(f"{step}/{len(train_ds) // train_loader.batch_size}, train_loss: {loss.item():.4f}")

epoch_len = len(train_ds) // train_loader.batch_size

epoch_loss /= step

epoch_loss_values.append(epoch_loss)

print(f"epoch {epoch + 1} average loss: {epoch_loss:.4f}")

if (epoch + 1) % val_interval == 0:

model.eval()

with torch.no_grad():

y_pred = torch.tensor([], dtype=torch.float32, device=device)

y = torch.tensor([], dtype=torch.long, device=device)

for val_data in val_loader:

val_images, val_labels = val_data[0].to(device), val_data[1].to(device)

y_pred = torch.cat([y_pred, model(val_images)], dim=0)

y = torch.cat([y, val_labels], dim=0)

y_onehot = [to_onehot(i) for i in y]

y_pred_act = [act(i) for i in y_pred]

auc_metric(y_pred_act, y_onehot)

auc_result = auc_metric.aggregate()

auc_metric.reset()

del y_pred_act, y_onehot

metric_values.append(auc_result)

acc_value = torch.eq(y_pred.argmax(dim=1), y)

acc_metric = acc_value.sum().item() / len(acc_value)

if acc_metric > best_metric:

best_metric = acc_metric

best_metric_epoch = epoch + 1

torch.save(model.state_dict(), 'best_metric_model.pth')

print('saved new best metric model')

print(f"current epoch: {epoch + 1} current AUC: {auc_result:.4f}"

f" current accuracy: {acc_metric:.4f} best AUC: {best_metric:.4f}"

f" at epoch: {best_metric_epoch}")

print(f"train completed, best_metric: {best_metric:.4f} at epoch: {best_metric_epoch}")

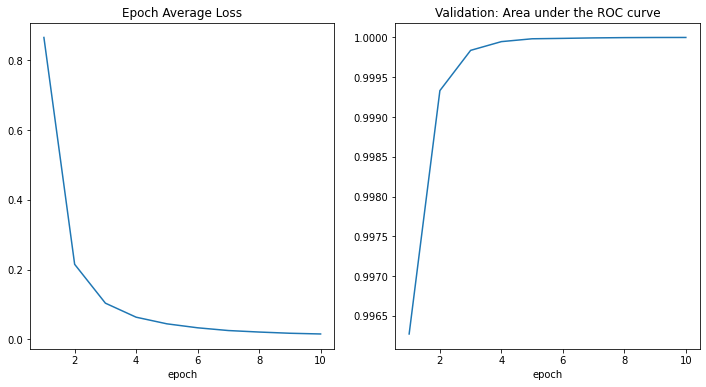

---------- epoch 1/4 (...) epoch 1 average loss: 0.8157 saved new best metric model current epoch: 1 current AUC: 0.9979 current accuracy: 0.9637 best AUC: 0.9637 at epoch: 1 ---------- epoch 2/4 (...) epoch 2 average loss: 0.1961 saved new best metric model current epoch: 2 current AUC: 0.9997 current accuracy: 0.9837 best AUC: 0.9837 at epoch: 2 ---------- epoch 3/4 (...) epoch 3 average loss: 0.0906 saved new best metric model current epoch: 3 current AUC: 0.9999 current accuracy: 0.9927 best AUC: 0.9927 at epoch: 3 ---------- epoch 4/4 (...) epoch 4 average loss: 0.0545 saved new best metric model current epoch: 4 current AUC: 1.0000 current accuracy: 0.9959 best AUC: 0.9959 at epoch: 4 train completed, best_metric: 0.9959 at epoch: 4

epoch 10 average loss: 0.0155 current epoch: 10 current AUC: 1.0000 current accuracy: 0.9986 best AUC: 0.9990 at epoch: 9 train completed, best_metric: 0.9990 at epoch: 9 CPU times: user 7min 38s, sys: 46.3 s, total: 8min 24s Wall time: 27min 14s

損失とメトリックのプロット

plt.figure('train', (12, 6))

plt.subplot(1, 2, 1)

plt.title("Epoch Average Loss")

x = [i + 1 for i in range(len(epoch_loss_values))]

y = epoch_loss_values

plt.xlabel('epoch')

plt.plot(x, y)

plt.subplot(1, 2, 2)

plt.title("Validation: Area under the ROC curve")

x = [val_interval * (i + 1) for i in range(len(metric_values))]

y = metric_values

plt.xlabel('epoch')

plt.plot(x, y)

plt.show()

テストデータセットでモデルを評価する

訓練と検証の後、検証テスト上のベストモデルを既に得ています。モデルが堅牢であることと過剰適合 (over-fitting) していないことを確認するためにテストデータセット上で評価する必要があります。分類レポートを生成するためにこれらの予測を使用します。

model.load_state_dict(torch.load('best_metric_model.pth'))

model.eval()

y_true = list()

y_pred = list()

with torch.no_grad():

for test_data in test_loader:

test_images, test_labels = test_data[0].to(device), test_data[1].to(device)

pred = model(test_images).argmax(dim=1)

for i in range(len(pred)):

y_true.append(test_labels[i].item())

y_pred.append(pred[i].item())

from sklearn.metrics import classification_report

print(classification_report(y_true, y_pred, target_names=class_names, digits=4))

precision recall f1-score support

AbdomenCT 0.9941 0.9912 0.9927 1025

BreastMRI 0.9955 0.9921 0.9938 884

CXR 0.9949 0.9959 0.9954 973

ChestCT 0.9922 1.0000 0.9961 1015

Hand 0.9969 0.9889 0.9929 989

HeadCT 0.9908 0.9959 0.9933 971

accuracy 0.9940 5857

macro avg 0.9941 0.9940 0.9940 5857

weighted avg 0.9940 0.9940 0.9940 5857

precision recall f1-score support

AbdomenCT 0.9990 0.9961 0.9976 1031

BreastMRI 0.9977 0.9988 0.9982 851

CXR 0.9990 0.9971 0.9980 1022

ChestCT 0.9971 1.0000 0.9986 1035

Hand 0.9969 0.9969 0.9969 983

HeadCT 0.9980 0.9990 0.9985 1001

accuracy 0.9980 5923

macro avg 0.9980 0.9980 0.9980 5923

weighted avg 0.9980 0.9980 0.9980 5923

以上

MONAI 1.0 : 概要 (README)

MONAI 1.0 : README (概要) (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 10/29/2022 (1.0.1)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

- 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション

- sales-info@classcat.com ; Web: www.classcat.com ; ClassCatJP

MONAI 1.0 : 概要 (README)

Medical Open Network for AI

MONAI は PyTorch エコシステム の一部で、ヘルスケア画像処理における深層学習のための PyTorch ベース、オープンソース のフレームワークです。その野心は :

- 共通基盤で協力して取り組める学術的、産業的そして臨床的な研究者のコミュニティを構築すること ;

- ヘルスケア画像処理のための最先端で、end-to-end な訓練ワークフローを作成すること ;

- 深層学習モデルを作成して評価するために最適化され標準化された方法を研究者に提供すること。

機能

マイルストーン・リリースの テクニカル・ハイライト と What’s New を参照してください。

- 多次元医用画像処理データのための柔軟な前処理 ;

- 既存のワークフロー内の簡単な統合のための構成的 & 可搬な API ;

- ネットワーク、損失、評価メトリクス等のためのドメイン固有な実装 ;

- 様々なユーザ専門性のためのカスタマイズ可能なデザイン ;

- マルチ GPU データ並列サポート。

インストール

現在のリリース をインストールするには、単純に以下を実行することができます :

pip install monai

他のインストール・オプションについては、インストールガイド を参照してください。

Getting Started

MedNIST デモ と MONAI for PyTorch Users が Colab で利用可能です。

サンプルとノートブック・チュートリアルは Project-MONAI/tutorials にあります。

技術文書は docs.monai.io で利用可能です。

モデル Zoo

MONAI モデル Zoo は研究者とデータサイエンティストがコミュニティからの最新の素晴らしいモデルを共有するための場所です。MONAI バンドル形式 の利用は MONAI でワークフローを構築し始める (Getting Started) ことを容易にします。

Contributing

MONAI への contribution (貢献) を行なうガイダンスについては、contributing ガイドライン を参照してください。

コミュニティ

Twitter @ProjectMONAI の会話に参加するか Slack チャネル に参加してください。

MONAI の GitHub Discussions タブ で質疑応答してください。

リンク

- Website : https://monai.io/

- API ドキュメント (マイルストーン) : https://docs.monai.io

- API ドキュメント (最新 dev) : https://docs.monai.io/en/latest/

- Code: https://github.com/Project-MONAI/MONAI

- Project tracker: https://github.com/Project-MONAI/MONAI/projects

- Issue tracker: https://github.com/Project-MONAI/MONAI/issues

- Wiki : https://github.com/Project-MONAI/MONAI/wiki

- Test status: https://github.com/Project-MONAI/MONAI/actions

- PyPI package: https://pypi.org/project/monai/

- conda-forge: https://anaconda.org/conda-forge/monai

- Weekly previews: https://pypi.org/project/monai-weekly/

- Docker Hub: https://hub.docker.com/r/projectmonai/monai

以上

MONAI 0.7 : tutorials : 3D セグメンテーション – 脳腫瘍 3D セグメンテーション

MONAI 0.7 : tutorials : 3D セグメンテーション – 脳腫瘍 3D セグメンテーション (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 11/08/2021 (0.7.0)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- テレワーク & オンライン授業を支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

- ウェビナー運用には弊社製品「ClassCat® Webinar」を利用しています。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

| 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション |

| E-Mail:sales-info@classcat.com ; WebSite: https://www.classcat.com/ ; Facebook |

MONAI 0.7 : tutorials : 3D セグメンテーション – 脳腫瘍 3D セグメンテーション

このチュートリアルは MSD 脳腫瘍データセットに基づくマルチラベル・タスクの訓練ワークフローを構築する方法を示します。

このチュートリアルはマルチラベル・セグメンテーション・タスクの訓練ワークフローを構築する方法を示します。

そしてそれは以下の機能を含みます :

- 辞書形式データのための変換。

- MONAI 変換 API に従って新しい変換を定義する。

- メタデータと共に Nifti 画像をロードし、画像のリストをロードしてそれらをスタックする。

- データ増強のために強度をランダムに調整する。

- 訓練と検証を高速化する Cache IO と変換。

- 3D セグメンテーション・タスクのための 3D SegResNet モデル, Dice 損失関数, 平均 Dice メトリック。

- 再現性のための決定論的訓練。

データセットは http://medicaldecathlon.com/ に由来します。

ターゲット: Gliomas segmentation necrotic/active tumour and oedema

Modality: Multimodal multisite MRI データ (FLAIR, T1w, T1gd,T2w)

サイズ: 750 4D volumes (484 訓練 + 266 テスト)

ソース: BRATS 2016 と 2017 データセット。

チャレンジ: Complex and heterogeneously-located targets

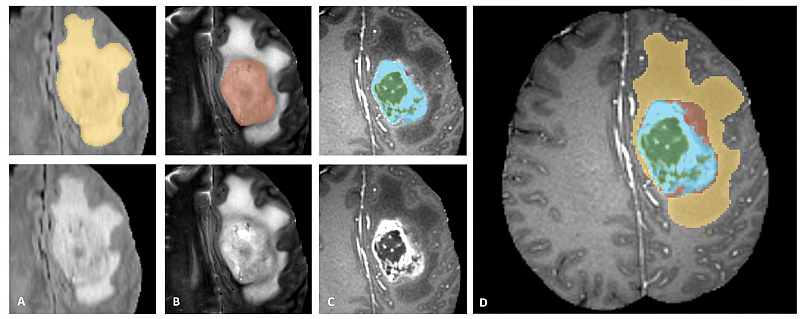

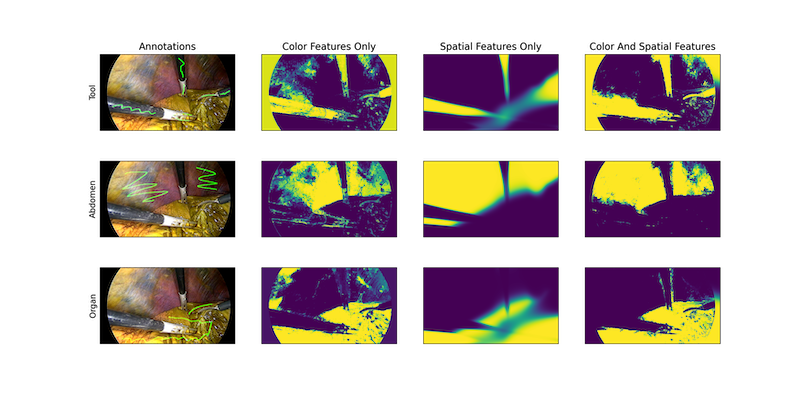

下図は、様々なモダリティでアノテートされている腫瘍部分領域の画像パッチ (左上) とデータセット全体のための最終的なラベル (右) を示します。(図は BraTS IEEE TMI 論文 から引用)

画像パッチは左から右へ以下を示します :

- T2-FLAIR で見える腫瘍全体 (黄色) (Fig.A)。

- T2 で見える腫瘍のコア (赤色) (Fig. B)。

- T1Gd で見える enhancing 腫瘍構造 (ライトブルー)、これはコアの嚢胞 (のうほう) (= cystic) / 壊死 (=necrotic) 成分 (緑色) を取り囲んでいます (Fig. C)。

- セグメンテーションは 腫瘍部分領域の最終的なラベル (Fig.D) を生成するために組み合わされます : 浮腫 (= edema) (黄色), non-enhancing ソリッドコア (赤色), 嚢胞/壊死コア (緑色), enhancing コア (青色) です。

環境のセットアップ

!python -c "import monai" || pip install -q "monai-weekly[nibabel, tqdm]"

!python -c "import matplotlib" || pip install -q matplotlib

#!pip install pytorch-ignite

%matplotlib inline

インポートのセットアップ

# Copyright 2020 MONAI Consortium

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

# http://www.apache.org/licenses/LICENSE-2.0

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

import os

import shutil

import tempfile

import time

import matplotlib.pyplot as plt

import numpy as np

from monai.apps import DecathlonDataset

from monai.config import print_config

from monai.data import DataLoader, decollate_batch

from monai.handlers.utils import from_engine

from monai.losses import DiceLoss

from monai.inferers import sliding_window_inference

from monai.metrics import DiceMetric

from monai.networks.nets import SegResNet

from monai.transforms import (

Activations,

Activationsd,

AsDiscrete,

AsDiscreted,

Compose,

Invertd,

LoadImaged,

MapTransform,

NormalizeIntensityd,

Orientationd,

RandFlipd,

RandScaleIntensityd,

RandShiftIntensityd,

RandSpatialCropd,

Spacingd,

EnsureChannelFirstd,

EnsureTyped,

EnsureType,

)

from monai.utils import set_determinism

import torch

print_config()

MONAI version: 0.4.0+618.g69b44596

Numpy version: 1.20.3

Pytorch version: 1.9.0a0+c3d40fd

MONAI flags: HAS_EXT = False, USE_COMPILED = False

MONAI rev id: 69b4459650fb6943b9e729e724254d2db2b2a1f2

Optional dependencies:

Pytorch Ignite version: 0.4.5

Nibabel version: 3.2.1

scikit-image version: 0.15.0

Pillow version: 8.3.1

Tensorboard version: 2.5.0

gdown version: 3.13.0

TorchVision version: 0.10.0a0

tqdm version: 4.53.0

lmdb version: 1.2.1

psutil version: 5.8.0

pandas version: 1.1.4

einops version: 0.3.0

For details about installing the optional dependencies, please visit:

https://docs.monai.io/en/latest/installation.html#installing-the-recommended-dependencies

データディレクトリのセットアップ

MONAI_DATA_DIRECTORY 環境変数でディレクトリを指定できます。これは結果をセーブしてダウンロードを再利用することを可能にします。指定されない場合、一時ディレクトリが使用されます。

directory = os.environ.get("MONAI_DATA_DIRECTORY")

root_dir = tempfile.mkdtemp() if directory is None else directory

print(root_dir)

/workspace/data/medical

再現性のために決定論的訓練を設定する

set_determinism(seed=0)

脳腫瘍のラベルを変換するための新しい変換を定義する

ここでは多クラスラベルを One-Hot 形式のマルチラベルのセグメンテーション・タスクに変換します。

class ConvertToMultiChannelBasedOnBratsClassesd(MapTransform):

"""

Convert labels to multi channels based on brats classes:

label 1 is the peritumoral edema

label 2 is the GD-enhancing tumor

label 3 is the necrotic and non-enhancing tumor core

The possible classes are TC (Tumor core), WT (Whole tumor)

and ET (Enhancing tumor).

"""

def __call__(self, data):

d = dict(data)

for key in self.keys:

result = []

# merge label 2 and label 3 to construct TC

result.append(np.logical_or(d[key] == 2, d[key] == 3))

# merge labels 1, 2 and 3 to construct WT

result.append(

np.logical_or(

np.logical_or(d[key] == 2, d[key] == 3), d[key] == 1

)

)

# label 2 is ET

result.append(d[key] == 2)

d[key] = np.stack(result, axis=0).astype(np.float32)

return d

訓練と検証のための変換のセットアップ

train_transform = Compose(

[

# load 4 Nifti images and stack them together

LoadImaged(keys=["image", "label"]),

EnsureChannelFirstd(keys="image"),

ConvertToMultiChannelBasedOnBratsClassesd(keys="label"),

Spacingd(

keys=["image", "label"],

pixdim=(1.0, 1.0, 1.0),

mode=("bilinear", "nearest"),

),

Orientationd(keys=["image", "label"], axcodes="RAS"),

RandSpatialCropd(keys=["image", "label"], roi_size=[224, 224, 144], random_size=False),

RandFlipd(keys=["image", "label"], prob=0.5, spatial_axis=0),

RandFlipd(keys=["image", "label"], prob=0.5, spatial_axis=1),

RandFlipd(keys=["image", "label"], prob=0.5, spatial_axis=2),

NormalizeIntensityd(keys="image", nonzero=True, channel_wise=True),

RandScaleIntensityd(keys="image", factors=0.1, prob=1.0),

RandShiftIntensityd(keys="image", offsets=0.1, prob=1.0),

EnsureTyped(keys=["image", "label"]),

]

)

val_transform = Compose(

[

LoadImaged(keys=["image", "label"]),

EnsureChannelFirstd(keys="image"),

ConvertToMultiChannelBasedOnBratsClassesd(keys="label"),

Spacingd(

keys=["image", "label"],

pixdim=(1.0, 1.0, 1.0),

mode=("bilinear", "nearest"),

),

Orientationd(keys=["image", "label"], axcodes="RAS"),

NormalizeIntensityd(keys="image", nonzero=True, channel_wise=True),

EnsureTyped(keys=["image", "label"]),

]

)

DecathlonDataset でデータを素早くロードする

ここではデータセットを自動的にダウンロードして抽出するために DecathlonDataset を使用します。それは MONAI CacheDataset を継承し、より少ないメモリを使用したい場合には、訓練のために N 項目をキャッシュするために cache_num=N を設定して検証のために総ての項目をキャッシュするために default args を使用できます、それはメモリサイズに依存します。

# here we don't cache any data in case out of memory issue

train_ds = DecathlonDataset(

root_dir=root_dir,

task="Task01_BrainTumour",

transform=train_transform,

section="training",

download=True,

cache_rate=0.0,

num_workers=4,

)

train_loader = DataLoader(train_ds, batch_size=1, shuffle=True, num_workers=4)

val_ds = DecathlonDataset(

root_dir=root_dir,

task="Task01_BrainTumour",

transform=val_transform,

section="validation",

download=False,

cache_rate=0.0,

num_workers=4,

)

val_loader = DataLoader(val_ds, batch_size=1, shuffle=False, num_workers=4)

Verified 'Task01_BrainTumour.tar', md5: 240a19d752f0d9e9101544901065d872. File exists: /workspace/data/medical/Task01_BrainTumour.tar, skipped downloading. Non-empty folder exists in /workspace/data/medical/Task01_BrainTumour, skipped extracting.

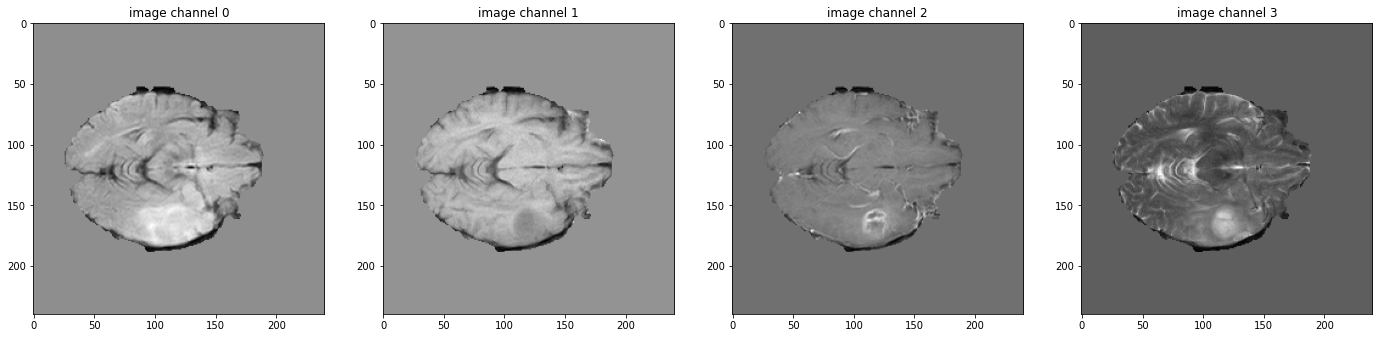

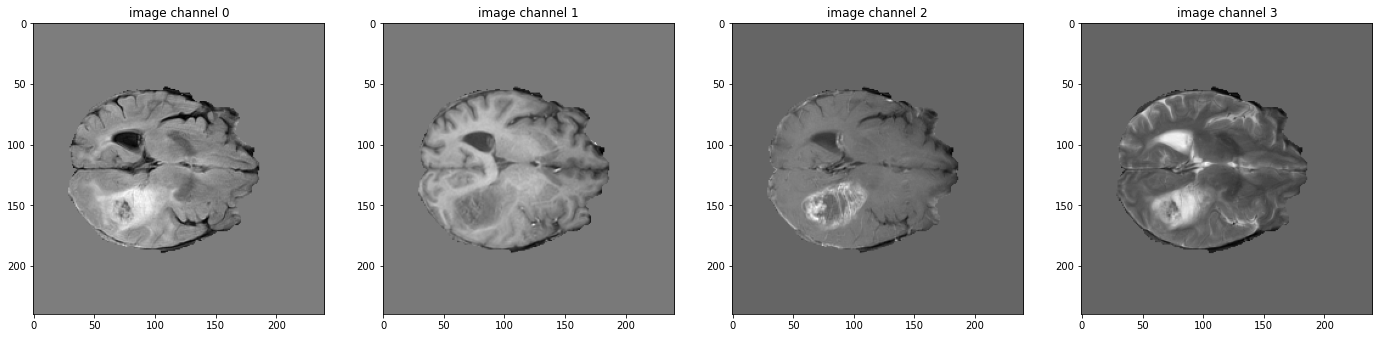

データ shape を確認して可視化する

# pick one image from DecathlonDataset to visualize and check the 4 channels

print(f"image shape: {val_ds[2]['image'].shape}")

plt.figure("image", (24, 6))

for i in range(4):

plt.subplot(1, 4, i + 1)

plt.title(f"image channel {i}")

plt.imshow(val_ds[2]["image"][i, :, :, 60].detach().cpu(), cmap="gray")

plt.show()

# also visualize the 3 channels label corresponding to this image

print(f"label shape: {val_ds[2]['label'].shape}")

plt.figure("label", (18, 6))

for i in range(3):

plt.subplot(1, 3, i + 1)

plt.title(f"label channel {i}")

plt.imshow(val_ds[2]["label"][i, :, :, 60].detach().cpu())

plt.show()

image shape: torch.Size([4, 240, 240, 155])

モデル, 損失, Optimizer を作成する

max_epochs = 300

val_interval = 1

VAL_AMP = True

# standard PyTorch program style: create SegResNet, DiceLoss and Adam optimizer

device = torch.device("cuda:0")

model = SegResNet(

blocks_down=[1, 2, 2, 4],

blocks_up=[1, 1, 1],

init_filters=16,

in_channels=4,

out_channels=3,

dropout_prob=0.2,

).to(device)

loss_function = DiceLoss(smooth_nr=0, smooth_dr=1e-5, squared_pred=True, to_onehot_y=False, sigmoid=True)

optimizer = torch.optim.Adam(model.parameters(), 1e-4, weight_decay=1e-5)

lr_scheduler = torch.optim.lr_scheduler.CosineAnnealingLR(optimizer, T_max=max_epochs)

dice_metric = DiceMetric(include_background=True, reduction="mean")

dice_metric_batch = DiceMetric(include_background=True, reduction="mean_batch")

post_trans = Compose(

[EnsureType(), Activations(sigmoid=True), AsDiscrete(threshold_values=True)]

)

# define inference method

def inference(input):

def _compute(input):

return sliding_window_inference(

inputs=input,

roi_size=(240, 240, 160),

sw_batch_size=1,

predictor=model,

overlap=0.5,

)

if VAL_AMP:

with torch.cuda.amp.autocast():

return _compute(input)

else:

return _compute(input)

# use amp to accelerate training

scaler = torch.cuda.amp.GradScaler()

# enable cuDNN benchmark

torch.backends.cudnn.benchmark = True

典型的な PyTorch 訓練プロセスの実行

best_metric = -1

best_metric_epoch = -1

best_metrics_epochs_and_time = [[], [], []]

epoch_loss_values = []

metric_values = []

metric_values_tc = []

metric_values_wt = []

metric_values_et = []

total_start = time.time()

for epoch in range(max_epochs):

epoch_start = time.time()

print("-" * 10)

print(f"epoch {epoch + 1}/{max_epochs}")

model.train()

epoch_loss = 0

step = 0

for batch_data in train_loader:

step_start = time.time()

step += 1

inputs, labels = (

batch_data["image"].to(device),

batch_data["label"].to(device),

)

optimizer.zero_grad()

with torch.cuda.amp.autocast():

outputs = model(inputs)

loss = loss_function(outputs, labels)

scaler.scale(loss).backward()

scaler.step(optimizer)

scaler.update()

epoch_loss += loss.item()

print(

f"{step}/{len(train_ds) // train_loader.batch_size}"

f", train_loss: {loss.item():.4f}"

f", step time: {(time.time() - step_start):.4f}"

)

lr_scheduler.step()

epoch_loss /= step

epoch_loss_values.append(epoch_loss)

print(f"epoch {epoch + 1} average loss: {epoch_loss:.4f}")

if (epoch + 1) % val_interval == 0:

model.eval()

with torch.no_grad():

for val_data in val_loader:

val_inputs, val_labels = (

val_data["image"].to(device),

val_data["label"].to(device),

)

val_outputs = inference(val_inputs)

val_outputs = [post_trans(i) for i in decollate_batch(val_outputs)]

dice_metric(y_pred=val_outputs, y=val_labels)

dice_metric_batch(y_pred=val_outputs, y=val_labels)

metric = dice_metric.aggregate().item()

metric_values.append(metric)

metric_batch = dice_metric_batch.aggregate()

metric_tc = metric_batch[0].item()

metric_values_tc.append(metric_tc)

metric_wt = metric_batch[1].item()

metric_values_wt.append(metric_wt)

metric_et = metric_batch[2].item()

metric_values_et.append(metric_et)

dice_metric.reset()

dice_metric_batch.reset()

if metric > best_metric:

best_metric = metric

best_metric_epoch = epoch + 1

best_metrics_epochs_and_time[0].append(best_metric)

best_metrics_epochs_and_time[1].append(best_metric_epoch)

best_metrics_epochs_and_time[2].append(time.time() - total_start)

torch.save(

model.state_dict(),

os.path.join(root_dir, "best_metric_model.pth"),

)

print("saved new best metric model")

print(

f"current epoch: {epoch + 1} current mean dice: {metric:.4f}"

f" tc: {metric_tc:.4f} wt: {metric_wt:.4f} et: {metric_et:.4f}"

f"\nbest mean dice: {best_metric:.4f}"

f" at epoch: {best_metric_epoch}"

)

print(f"time consuming of epoch {epoch + 1} is: {(time.time() - epoch_start):.4f}")

total_time = time.time() - total_start

print(f"train completed, best_metric: {best_metric:.4f} at epoch: {best_metric_epoch}, total time: {total_time}.")

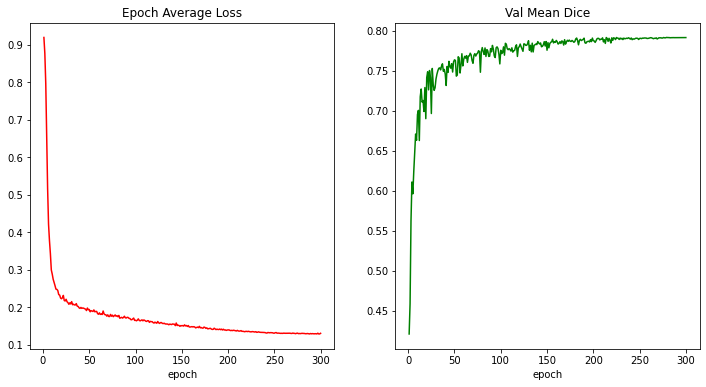

train completed, best_metric: 0.7914 at epoch: 279, total time: 90155.70936012268.

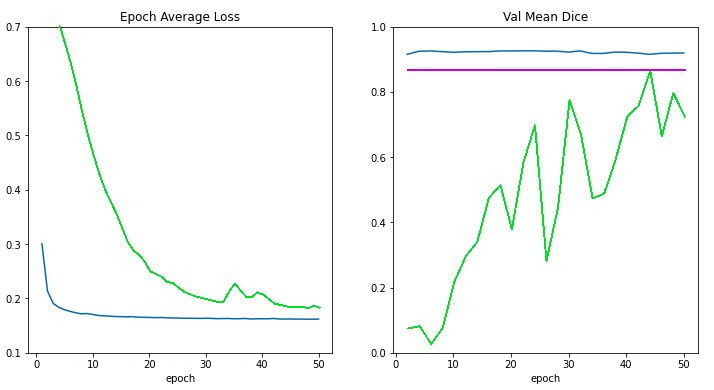

損失とメトリックのプロット

plt.figure("train", (12, 6))

plt.subplot(1, 2, 1)

plt.title("Epoch Average Loss")

x = [i + 1 for i in range(len(epoch_loss_values))]

y = epoch_loss_values

plt.xlabel("epoch")

plt.plot(x, y, color="red")

plt.subplot(1, 2, 2)

plt.title("Val Mean Dice")

x = [val_interval * (i + 1) for i in range(len(metric_values))]

y = metric_values

plt.xlabel("epoch")

plt.plot(x, y, color="green")

plt.show()

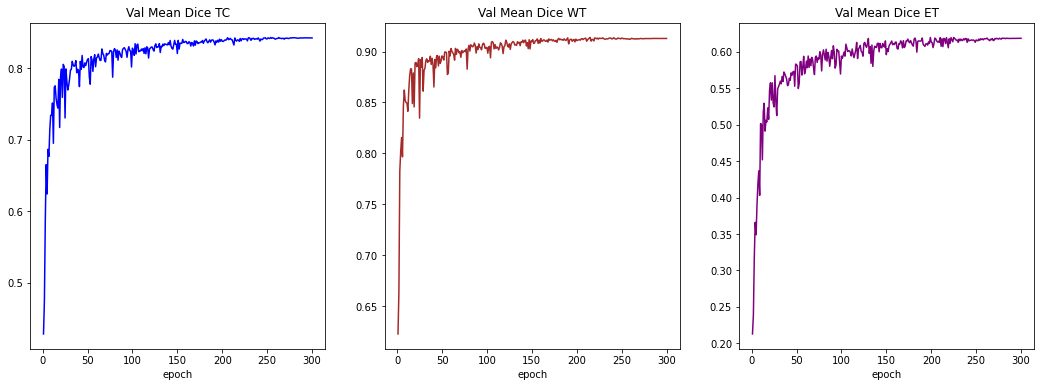

plt.figure("train", (18, 6))

plt.subplot(1, 3, 1)

plt.title("Val Mean Dice TC")

x = [val_interval * (i + 1) for i in range(len(metric_values_tc))]

y = metric_values_tc

plt.xlabel("epoch")

plt.plot(x, y, color="blue")

plt.subplot(1, 3, 2)

plt.title("Val Mean Dice WT")

x = [val_interval * (i + 1) for i in range(len(metric_values_wt))]

y = metric_values_wt

plt.xlabel("epoch")

plt.plot(x, y, color="brown")

plt.subplot(1, 3, 3)

plt.title("Val Mean Dice ET")

x = [val_interval * (i + 1) for i in range(len(metric_values_et))]

y = metric_values_et

plt.xlabel("epoch")

plt.plot(x, y, color="purple")

plt.show()

入力画像とラベルでベストモデル出力を確認する

model.load_state_dict(

torch.load(os.path.join(root_dir, "best_metric_model.pth"))

)

model.eval()

with torch.no_grad():

# select one image to evaluate and visualize the model output

val_input = val_ds[6]["image"].unsqueeze(0).to(device)

roi_size = (128, 128, 64)

sw_batch_size = 4

val_output = inference(val_input)

val_output = post_trans(val_output[0])

plt.figure("image", (24, 6))

for i in range(4):

plt.subplot(1, 4, i + 1)

plt.title(f"image channel {i}")

plt.imshow(val_ds[6]["image"][i, :, :, 70].detach().cpu(), cmap="gray")

plt.show()

# visualize the 3 channels label corresponding to this image

plt.figure("label", (18, 6))

for i in range(3):

plt.subplot(1, 3, i + 1)

plt.title(f"label channel {i}")

plt.imshow(val_ds[6]["label"][i, :, :, 70].detach().cpu())

plt.show()

# visualize the 3 channels model output corresponding to this image

plt.figure("output", (18, 6))

for i in range(3):

plt.subplot(1, 3, i + 1)

plt.title(f"output channel {i}")

plt.imshow(val_output[i, :, :, 70].detach().cpu())

plt.show()

元の画像 spacings 上の評価

val_org_transforms = Compose(

[

LoadImaged(keys=["image", "label"]),

EnsureChannelFirstd(keys=["image"]),

ConvertToMultiChannelBasedOnBratsClassesd(keys="label"),

Spacingd(keys=["image"], pixdim=(1.0, 1.0, 1.0), mode="bilinear"),

Orientationd(keys=["image"], axcodes="RAS"),

NormalizeIntensityd(keys="image", nonzero=True, channel_wise=True),

EnsureTyped(keys=["image", "label"]),

]

)

val_org_ds = DecathlonDataset(

root_dir=root_dir,

task="Task01_BrainTumour",

transform=val_org_transforms,

section="validation",

download=False,

num_workers=4,

cache_num=0,

)

val_org_loader = DataLoader(val_org_ds, batch_size=1, shuffle=False, num_workers=4)

post_transforms = Compose([

EnsureTyped(keys="pred"),

Invertd(

keys="pred",

transform=val_org_transforms,

orig_keys="image",

meta_keys="pred_meta_dict",

orig_meta_keys="image_meta_dict",

meta_key_postfix="meta_dict",

nearest_interp=False,

to_tensor=True,

),

Activationsd(keys="pred", sigmoid=True),

AsDiscreted(keys="pred", threshold_values=True),

])

model.load_state_dict(torch.load(

os.path.join(root_dir, "best_metric_model.pth")))

model.eval()

with torch.no_grad():

for val_data in val_org_loader:

val_inputs = val_data["image"].to(device)

val_data["pred"] = inference(val_inputs)

val_data = [post_transforms(i) for i in decollate_batch(val_data)]

val_outputs, val_labels = from_engine(["pred", "label"])(val_data)

dice_metric(y_pred=val_outputs, y=val_labels)

dice_metric_batch(y_pred=val_outputs, y=val_labels)

metric_org = dice_metric.aggregate().item()

metric_batch_org = dice_metric_batch.aggregate()

dice_metric.reset()

dice_metric_batch.reset()

metric_tc, metric_wt, metric_et = metric_batch[0].item(), metric_batch[1].item(), metric_batch[2].item()

print("Metric on original image spacing: ", metric)

print(f"metric_tc: {metric_tc:.4f}")

print(f"metric_wt: {metric_wt:.4f}")

print(f"metric_et: {metric_et:.4f}")

Metric on original image spacing: 0.7912478446960449 metric_tc: 0.8422 metric_wt: 0.9129 metric_et: 0.6187

データディレクトリのクリーンアップ

一時ディレクトリが使用された場合ディレクトリを削除します。

if directory is None:

shutil.rmtree(root_dir)

以上

MONAI 0.7 : tutorials : 3D セグメンテーション – UNet による 3D セグメンテーション

MONAI 0.7 : tutorials : 3D セグメンテーション – UNet による 3D セグメンテーション (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 11/07/2021 (0.7.0)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- テレワーク & オンライン授業を支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

- ウェビナー運用には弊社製品「ClassCat® Webinar」を利用しています。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

| 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション |

| E-Mail:sales-info@classcat.com ; WebSite: https://www.classcat.com/ ; Facebook |

MONAI 0.7 : tutorials : 3D セグメンテーション – UNet による 3D セグメンテーション

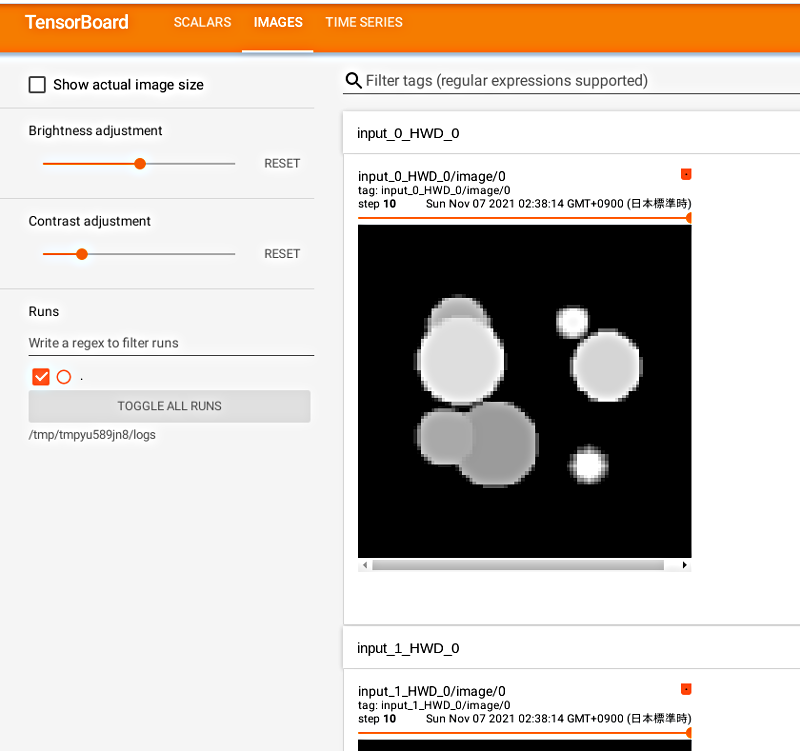

このノートブックは合成データセットに基づく 3D セグメンテーションの end-to-end な訓練 & 評価サンプルです。サンプルは PyTorch Ignite プログラムで MONAI の幾つかの主要な機能を示します、特に医療ドメイン固有の変換とプロファイリング (ロギング, TensorBoard, MLFlow 等) のためのイベントハンドラを使用します。

環境のセットアップ

!python -c "import monai" || pip install -q "monai-weekly[ignite, nibabel, tensorboard, mlflow]"

インポートのセットアップ

# Copyright 2020 MONAI Consortium

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

# http://www.apache.org/licenses/LICENSE-2.0

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

import glob

import logging

import os

from pathlib import Path

import shutil

import sys

import tempfile

import nibabel as nib

import numpy as np

from monai.config import print_config

from monai.data import ArrayDataset, create_test_image_3d, decollate_batch

from monai.handlers import (

MeanDice,

MLFlowHandler,

StatsHandler,

TensorBoardImageHandler,

TensorBoardStatsHandler,

)

from monai.losses import DiceLoss

from monai.networks.nets import UNet

from monai.transforms import (

Activations,

AddChannel,

AsDiscrete,

Compose,

LoadImage,

RandSpatialCrop,

Resize,

ScaleIntensity,

EnsureType,

)

from monai.utils import first

import ignite

import torch

print_config()

データディレクトリのセットアップ

MONAI_DATA_DIRECTORY 環境変数でディレクトリを指定できます。これは結果をセーブしてダウンロードを再利用することを可能にします。指定されない場合、一時ディレクトリが使用されます。

directory = os.environ.get("MONAI_DATA_DIRECTORY")

root_dir = tempfile.mkdtemp() if directory is None else directory

print(root_dir)

/workspace/data/medical

ロギングのセットアップ

logging.basicConfig(stream=sys.stdout, level=logging.INFO)

デモデータのセットアップ

for i in range(40):

im, seg = create_test_image_3d(128, 128, 128, num_seg_classes=1)

n = nib.Nifti1Image(im, np.eye(4))

nib.save(n, os.path.join(root_dir, f"im{i}.nii.gz"))

n = nib.Nifti1Image(seg, np.eye(4))

nib.save(n, os.path.join(root_dir, f"seg{i}.nii.gz"))

images = sorted(glob.glob(os.path.join(root_dir, "im*.nii.gz")))

segs = sorted(glob.glob(os.path.join(root_dir, "seg*.nii.gz")))

変換, データセットのセットアップ

# Define transforms for image and segmentation

imtrans = Compose(

[

LoadImage(image_only=True),

ScaleIntensity(),

AddChannel(),

RandSpatialCrop((96, 96, 96), random_size=False),

EnsureType(),

]

)

segtrans = Compose(

[

LoadImage(image_only=True),

AddChannel(),

RandSpatialCrop((96, 96, 96), random_size=False),

EnsureType(),

]

)

# Define nifti dataset, dataloader

ds = ArrayDataset(images, imtrans, segs, segtrans)

loader = torch.utils.data.DataLoader(

ds, batch_size=10, num_workers=2, pin_memory=torch.cuda.is_available()

)

im, seg = first(loader)

print(im.shape, seg.shape)

torch.Size([10, 1, 96, 96, 96]) torch.Size([10, 1, 96, 96, 96])

モデル, 損失, Optimizer を作成する

# Create UNet, DiceLoss and Adam optimizer

device = torch.device("cuda:0")

net = UNet(

spatial_dims=3,

in_channels=1,

out_channels=1,

channels=(16, 32, 64, 128, 256),

strides=(2, 2, 2, 2),

num_res_units=2,

).to(device)

loss = DiceLoss(sigmoid=True)

lr = 1e-3

opt = torch.optim.Adam(net.parameters(), lr)

ignite を使用して supervised_trainer を作成する

# Create trainer

trainer = ignite.engine.create_supervised_trainer(

net, opt, loss, device, False

)

チェックポインティングとロギングのためのイベントハンドラのセットアップ

# optional section for checkpoint and tensorboard logging

# adding checkpoint handler to save models (network

# params and optimizer stats) during training

log_dir = os.path.join(root_dir, "logs")

checkpoint_handler = ignite.handlers.ModelCheckpoint(

log_dir, "net", n_saved=10, require_empty=False

)

trainer.add_event_handler(

event_name=ignite.engine.Events.EPOCH_COMPLETED,

handler=checkpoint_handler,

to_save={"net": net, "opt": opt},

)

# StatsHandler prints loss at every iteration

# user can also customize print functions and can use output_transform to convert

# engine.state.output if it's not a loss value

train_stats_handler = StatsHandler(name="trainer", output_transform=lambda x: x)

train_stats_handler.attach(trainer)

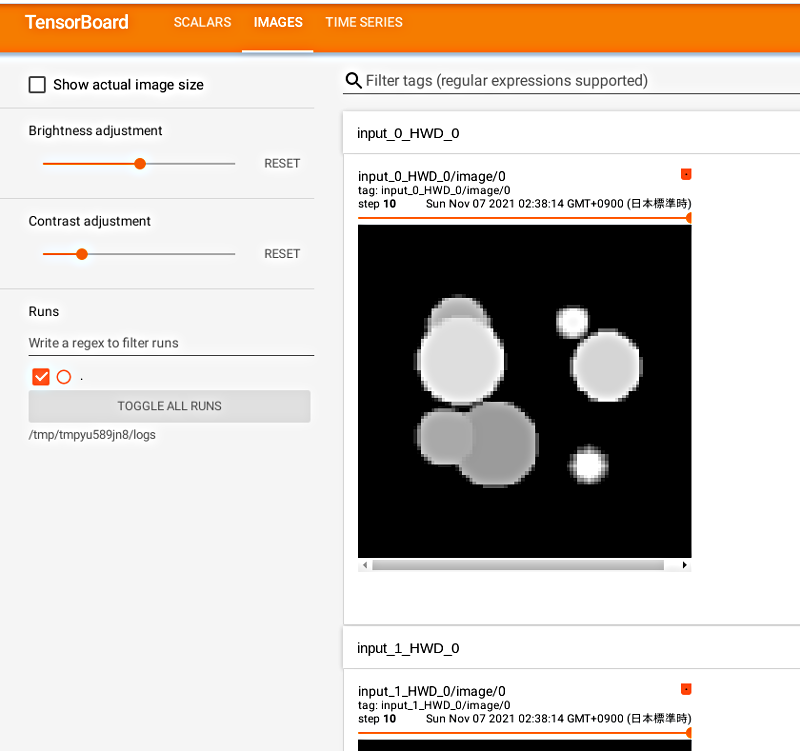

# TensorBoardStatsHandler plots loss at every iteration

train_tensorboard_stats_handler = TensorBoardStatsHandler(log_dir=log_dir, output_transform=lambda x: x)

train_tensorboard_stats_handler.attach(trainer)

# MLFlowHandler plots loss at every iteration on MLFlow web UI

mlflow_dir = os.path.join(log_dir, "mlruns")

train_mlflow_handler = MLFlowHandler(tracking_uri=Path(mlflow_dir).as_uri(), output_transform=lambda x: x)

train_mlflow_handler.attach(trainer)

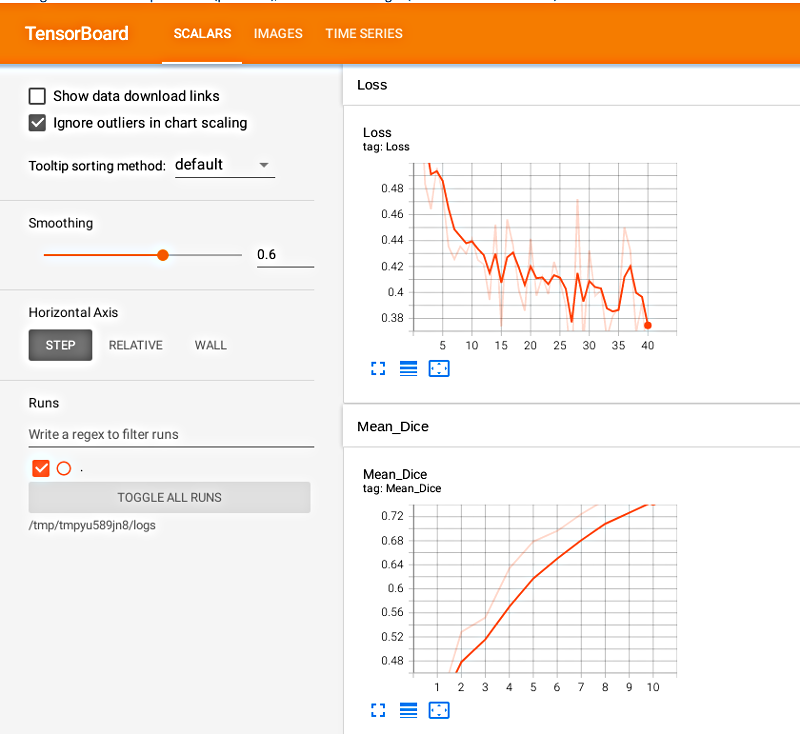

N エポック毎の検証の追加

# optional section for model validation during training

validation_every_n_epochs = 1

# Set parameters for validation

metric_name = "Mean_Dice"

# add evaluation metric to the evaluator engine

val_metrics = {metric_name: MeanDice()}

post_pred = Compose(

[EnsureType(), Activations(sigmoid=True), AsDiscrete(threshold_values=True)]

)

post_label = Compose([EnsureType(), AsDiscrete(threshold_values=True)])

# Ignite evaluator expects batch=(img, seg) and

# returns output=(y_pred, y) at every iteration,

# user can add output_transform to return other values

evaluator = ignite.engine.create_supervised_evaluator(

net,

val_metrics,

device,

True,

output_transform=lambda x, y, y_pred: (

[post_pred(i) for i in decollate_batch(y_pred)],

[post_label(i) for i in decollate_batch(y)]

),

)

# create a validation data loader

val_imtrans = Compose(

[

LoadImage(image_only=True),

ScaleIntensity(),

AddChannel(),

Resize((96, 96, 96)),

EnsureType(),

]

)

val_segtrans = Compose(

[

LoadImage(image_only=True),

AddChannel(),

Resize((96, 96, 96)),

EnsureType(),

]

)

val_ds = ArrayDataset(images[21:], val_imtrans, segs[21:], val_segtrans)

val_loader = torch.utils.data.DataLoader(

val_ds, batch_size=5, num_workers=8, pin_memory=torch.cuda.is_available()

)

@trainer.on(