MONAI 0.7 : tutorials : 3D セグメンテーション – UNet による 3D セグメンテーション (翻訳/解説)

翻訳 : (株)クラスキャット セールスインフォメーション

作成日時 : 11/07/2021 (0.7.0)

* 本ページは、MONAI の以下のドキュメントを翻訳した上で適宜、補足説明したものです:

* サンプルコードの動作確認はしておりますが、必要な場合には適宜、追加改変しています。

* ご自由にリンクを張って頂いてかまいませんが、sales-info@classcat.com までご一報いただけると嬉しいです。

- 人工知能研究開発支援

- 人工知能研修サービス(経営者層向けオンサイト研修)

- テクニカルコンサルティングサービス

- 実証実験(プロトタイプ構築)

- アプリケーションへの実装

- 人工知能研修サービス

- PoC(概念実証)を失敗させないための支援

- テレワーク & オンライン授業を支援

- お住まいの地域に関係なく Web ブラウザからご参加頂けます。事前登録 が必要ですのでご注意ください。

- ウェビナー運用には弊社製品「ClassCat® Webinar」を利用しています。

◆ お問合せ : 本件に関するお問い合わせ先は下記までお願いいたします。

| 株式会社クラスキャット セールス・マーケティング本部 セールス・インフォメーション |

| E-Mail:sales-info@classcat.com ; WebSite: https://www.classcat.com/ ; Facebook |

MONAI 0.7 : tutorials : 3D セグメンテーション – UNet による 3D セグメンテーション

このノートブックは合成データセットに基づく 3D セグメンテーションの end-to-end な訓練 & 評価サンプルです。サンプルは PyTorch Ignite プログラムで MONAI の幾つかの主要な機能を示します、特に医療ドメイン固有の変換とプロファイリング (ロギング, TensorBoard, MLFlow 等) のためのイベントハンドラを使用します。

環境のセットアップ

!python -c "import monai" || pip install -q "monai-weekly[ignite, nibabel, tensorboard, mlflow]"

インポートのセットアップ

# Copyright 2020 MONAI Consortium

# Licensed under the Apache License, Version 2.0 (the "License");

# you may not use this file except in compliance with the License.

# You may obtain a copy of the License at

# http://www.apache.org/licenses/LICENSE-2.0

# Unless required by applicable law or agreed to in writing, software

# distributed under the License is distributed on an "AS IS" BASIS,

# WITHOUT WARRANTIES OR CONDITIONS OF ANY KIND, either express or implied.

# See the License for the specific language governing permissions and

# limitations under the License.

import glob

import logging

import os

from pathlib import Path

import shutil

import sys

import tempfile

import nibabel as nib

import numpy as np

from monai.config import print_config

from monai.data import ArrayDataset, create_test_image_3d, decollate_batch

from monai.handlers import (

MeanDice,

MLFlowHandler,

StatsHandler,

TensorBoardImageHandler,

TensorBoardStatsHandler,

)

from monai.losses import DiceLoss

from monai.networks.nets import UNet

from monai.transforms import (

Activations,

AddChannel,

AsDiscrete,

Compose,

LoadImage,

RandSpatialCrop,

Resize,

ScaleIntensity,

EnsureType,

)

from monai.utils import first

import ignite

import torch

print_config()

データディレクトリのセットアップ

MONAI_DATA_DIRECTORY 環境変数でディレクトリを指定できます。これは結果をセーブしてダウンロードを再利用することを可能にします。指定されない場合、一時ディレクトリが使用されます。

directory = os.environ.get("MONAI_DATA_DIRECTORY")

root_dir = tempfile.mkdtemp() if directory is None else directory

print(root_dir)

/workspace/data/medical

ロギングのセットアップ

logging.basicConfig(stream=sys.stdout, level=logging.INFO)

デモデータのセットアップ

for i in range(40):

im, seg = create_test_image_3d(128, 128, 128, num_seg_classes=1)

n = nib.Nifti1Image(im, np.eye(4))

nib.save(n, os.path.join(root_dir, f"im{i}.nii.gz"))

n = nib.Nifti1Image(seg, np.eye(4))

nib.save(n, os.path.join(root_dir, f"seg{i}.nii.gz"))

images = sorted(glob.glob(os.path.join(root_dir, "im*.nii.gz")))

segs = sorted(glob.glob(os.path.join(root_dir, "seg*.nii.gz")))

変換, データセットのセットアップ

# Define transforms for image and segmentation

imtrans = Compose(

[

LoadImage(image_only=True),

ScaleIntensity(),

AddChannel(),

RandSpatialCrop((96, 96, 96), random_size=False),

EnsureType(),

]

)

segtrans = Compose(

[

LoadImage(image_only=True),

AddChannel(),

RandSpatialCrop((96, 96, 96), random_size=False),

EnsureType(),

]

)

# Define nifti dataset, dataloader

ds = ArrayDataset(images, imtrans, segs, segtrans)

loader = torch.utils.data.DataLoader(

ds, batch_size=10, num_workers=2, pin_memory=torch.cuda.is_available()

)

im, seg = first(loader)

print(im.shape, seg.shape)

torch.Size([10, 1, 96, 96, 96]) torch.Size([10, 1, 96, 96, 96])

モデル, 損失, Optimizer を作成する

# Create UNet, DiceLoss and Adam optimizer

device = torch.device("cuda:0")

net = UNet(

spatial_dims=3,

in_channels=1,

out_channels=1,

channels=(16, 32, 64, 128, 256),

strides=(2, 2, 2, 2),

num_res_units=2,

).to(device)

loss = DiceLoss(sigmoid=True)

lr = 1e-3

opt = torch.optim.Adam(net.parameters(), lr)

ignite を使用して supervised_trainer を作成する

# Create trainer

trainer = ignite.engine.create_supervised_trainer(

net, opt, loss, device, False

)

チェックポインティングとロギングのためのイベントハンドラのセットアップ

# optional section for checkpoint and tensorboard logging

# adding checkpoint handler to save models (network

# params and optimizer stats) during training

log_dir = os.path.join(root_dir, "logs")

checkpoint_handler = ignite.handlers.ModelCheckpoint(

log_dir, "net", n_saved=10, require_empty=False

)

trainer.add_event_handler(

event_name=ignite.engine.Events.EPOCH_COMPLETED,

handler=checkpoint_handler,

to_save={"net": net, "opt": opt},

)

# StatsHandler prints loss at every iteration

# user can also customize print functions and can use output_transform to convert

# engine.state.output if it's not a loss value

train_stats_handler = StatsHandler(name="trainer", output_transform=lambda x: x)

train_stats_handler.attach(trainer)

# TensorBoardStatsHandler plots loss at every iteration

train_tensorboard_stats_handler = TensorBoardStatsHandler(log_dir=log_dir, output_transform=lambda x: x)

train_tensorboard_stats_handler.attach(trainer)

# MLFlowHandler plots loss at every iteration on MLFlow web UI

mlflow_dir = os.path.join(log_dir, "mlruns")

train_mlflow_handler = MLFlowHandler(tracking_uri=Path(mlflow_dir).as_uri(), output_transform=lambda x: x)

train_mlflow_handler.attach(trainer)

N エポック毎の検証の追加

# optional section for model validation during training

validation_every_n_epochs = 1

# Set parameters for validation

metric_name = "Mean_Dice"

# add evaluation metric to the evaluator engine

val_metrics = {metric_name: MeanDice()}

post_pred = Compose(

[EnsureType(), Activations(sigmoid=True), AsDiscrete(threshold_values=True)]

)

post_label = Compose([EnsureType(), AsDiscrete(threshold_values=True)])

# Ignite evaluator expects batch=(img, seg) and

# returns output=(y_pred, y) at every iteration,

# user can add output_transform to return other values

evaluator = ignite.engine.create_supervised_evaluator(

net,

val_metrics,

device,

True,

output_transform=lambda x, y, y_pred: (

[post_pred(i) for i in decollate_batch(y_pred)],

[post_label(i) for i in decollate_batch(y)]

),

)

# create a validation data loader

val_imtrans = Compose(

[

LoadImage(image_only=True),

ScaleIntensity(),

AddChannel(),

Resize((96, 96, 96)),

EnsureType(),

]

)

val_segtrans = Compose(

[

LoadImage(image_only=True),

AddChannel(),

Resize((96, 96, 96)),

EnsureType(),

]

)

val_ds = ArrayDataset(images[21:], val_imtrans, segs[21:], val_segtrans)

val_loader = torch.utils.data.DataLoader(

val_ds, batch_size=5, num_workers=8, pin_memory=torch.cuda.is_available()

)

@trainer.on(

ignite.engine.Events.EPOCH_COMPLETED(every=validation_every_n_epochs)

)

def run_validation(engine):

evaluator.run(val_loader)

# Add stats event handler to print validation stats via evaluator

val_stats_handler = StatsHandler(

name="evaluator",

# no need to print loss value, so disable per iteration output

output_transform=lambda x: None,

# fetch global epoch number from trainer

global_epoch_transform=lambda x: trainer.state.epoch,

)

val_stats_handler.attach(evaluator)

# add handler to record metrics to TensorBoard at every validation epoch

val_tensorboard_stats_handler = TensorBoardStatsHandler(

log_dir=log_dir,

# no need to plot loss value, so disable per iteration output

output_transform=lambda x: None,

# fetch global epoch number from trainer

global_epoch_transform=lambda x: trainer.state.epoch,

)

val_tensorboard_stats_handler.attach(evaluator)

# add handler to record metrics to MLFlow at every validation epoch

val_mlflow_handler = MLFlowHandler(

tracking_uri=Path(mlflow_dir).as_uri(),

# no need to plot loss value, so disable per iteration output

output_transform=lambda x: None,

# fetch global epoch number from trainer

global_epoch_transform=lambda x: trainer.state.epoch,

)

val_mlflow_handler.attach(evaluator)

# add handler to draw the first image and the corresponding

# label and model output in the last batch

# here we draw the 3D output as GIF format along Depth

# axis, at every validation epoch

val_tensorboard_image_handler = TensorBoardImageHandler(

log_dir=log_dir,

batch_transform=lambda batch: (batch[0], batch[1]),

output_transform=lambda output: output[0],

global_iter_transform=lambda x: trainer.state.epoch,

)

evaluator.add_event_handler(

event_name=ignite.engine.Events.EPOCH_COMPLETED,

handler=val_tensorboard_image_handler,

)

訓練ループの実行

# create a training data loader

train_ds = ArrayDataset(images[:20], imtrans, segs[:20], segtrans)

train_loader = torch.utils.data.DataLoader(

train_ds,

batch_size=5,

shuffle=True,

num_workers=8,

pin_memory=torch.cuda.is_available(),

)

max_epochs = 10

state = trainer.run(train_loader, max_epochs)

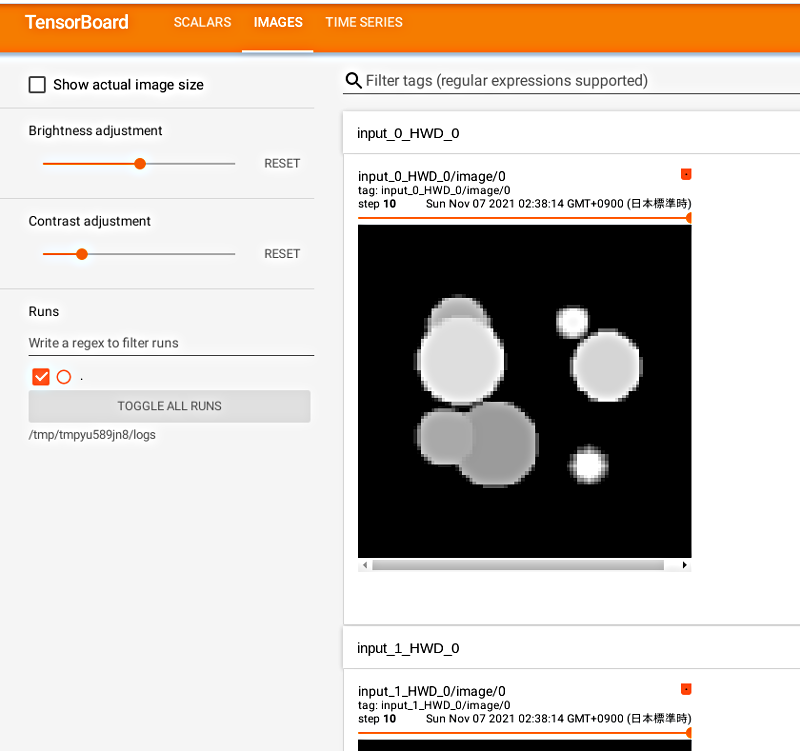

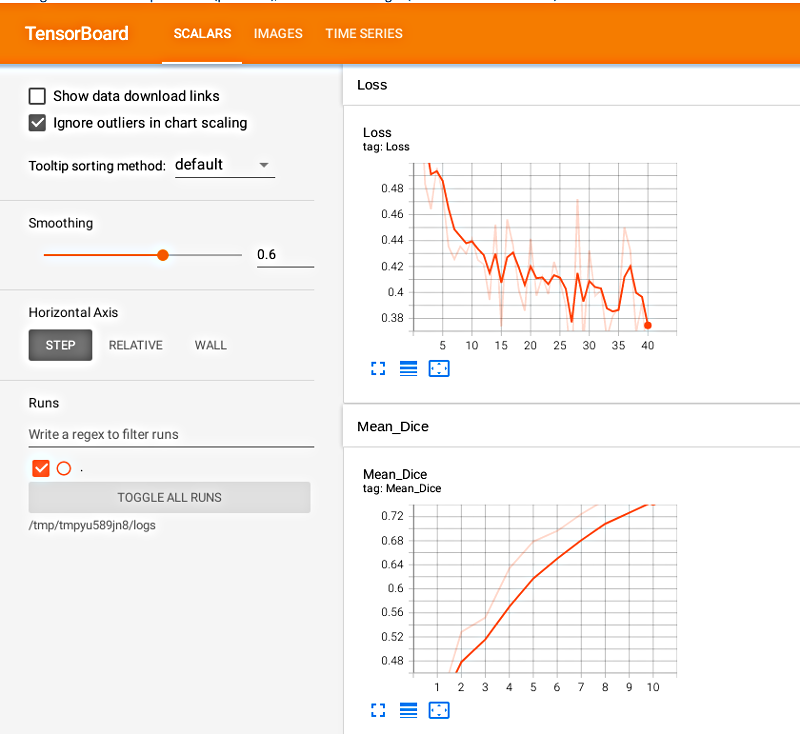

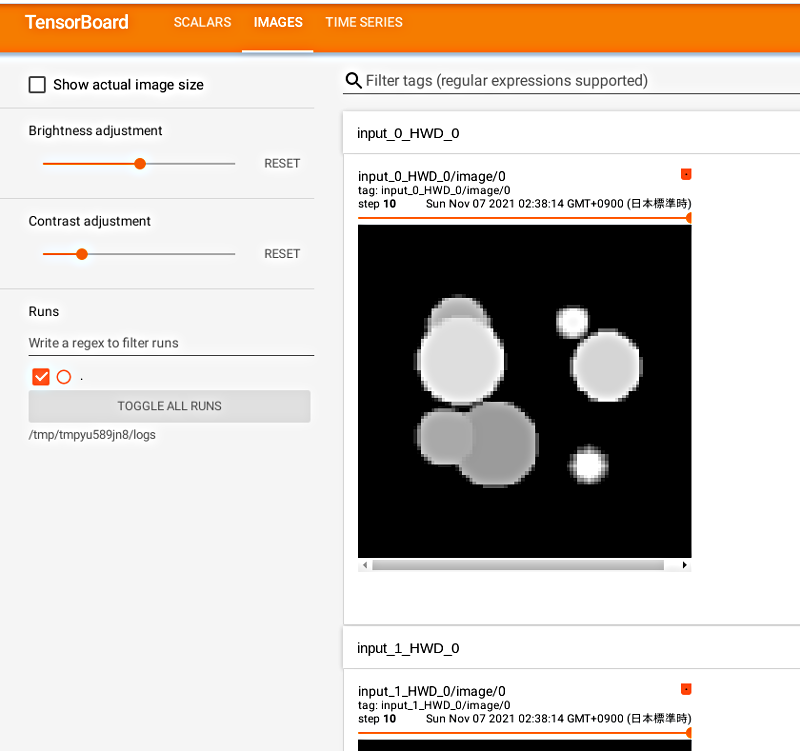

Tensorboard ログの可視化

%load_ext tensorboard

%tensorboard --logdir=log_dir

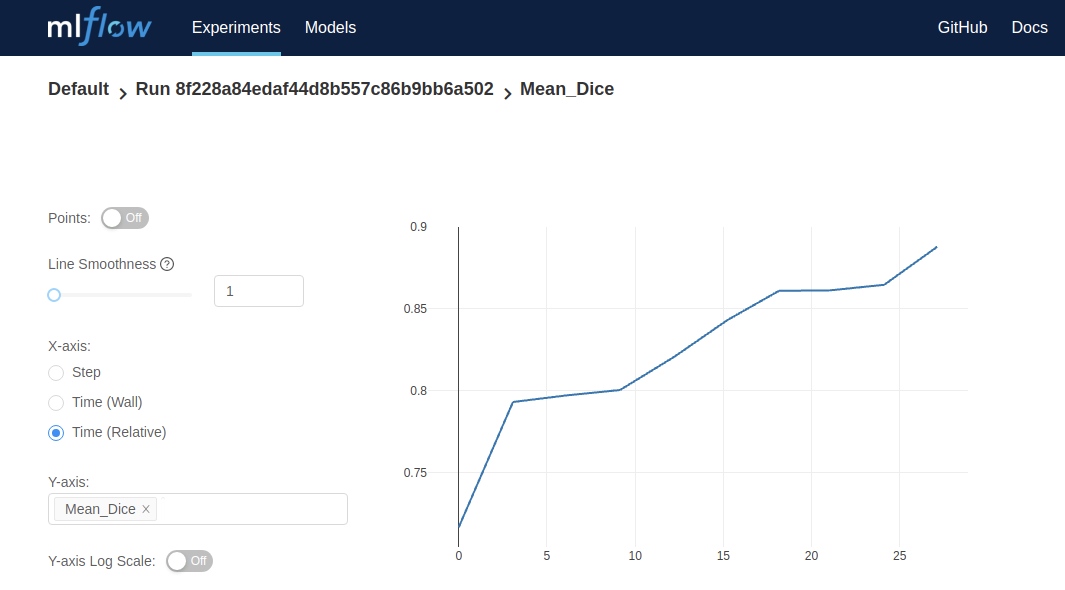

MLFlow で訓練ステータスを可視化する

mlflow は IPython コンポーネントではないので、log_dir に切り替えて MLFlow UI を起動するためにコマンド mlflow ui を実行してください。

MLFlow UI で予想される訓練曲線です :

データディレクトリのクリーンアップ

一時ディレクトリが使用された場合ディレクトリを削除します。

if directory is None:

shutil.rmtree(root_dir)

以上